Ci-dessous une sélection de guides et manuels de référence dans le domaine du suivi évaluation. Classés par date de diffusion. Ou encore en distinguant les manuels qui font explicitement référence à du SEA (suivi, évaluation, apprentissage) ou encore SERA (suivi, évaluation, redevabilité, apprentissage). Ou encore les manuels qui vous accompagne à mettre en place un système de suivi et évaluation.

Guide élaboration de système de SE

- 2017 – Systèmes de suivi & d’évaluation et de comptabilité : manuel à l’usage du programme de leadership et de transformation pour la mise en place et l’administration de socles de protection sociale en Afrique, OIT

Ce module TRANSFORM est une référence spécifique pour le S&E des systèmes de protection sociale dans le contexte africain. L’objet est d’améliorer l’action publique dans le secteur du développement social, une collaboration entre les agences internationales (OIT, UNICEF, PNUD sont partenaires de TRANSFORM ) et les socles de protection sociale développés par les gouvernements.

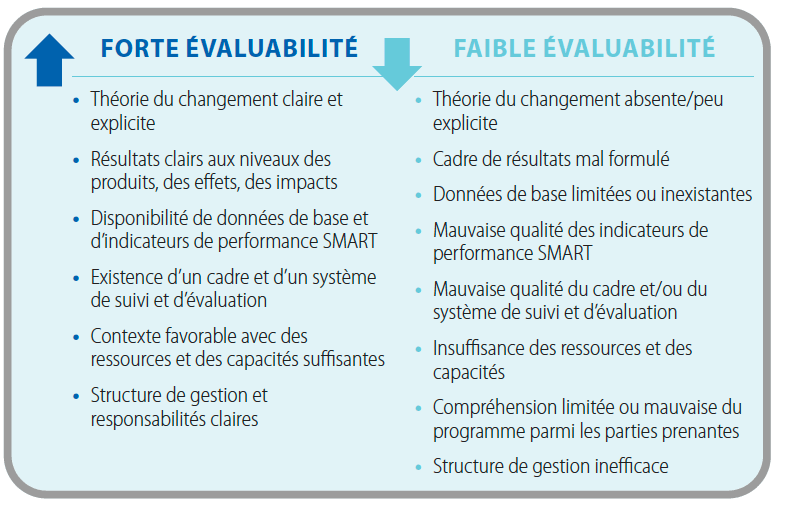

Le guide met notamment en lumière la nécessité d’équilibrer l’offre de données de S&E (capacités de production) et la demande (besoins des décideurs). Pour cela, il détaille les composantes clés d’un système de S&E : l’élaboration d’une théorie du changement et d’un cadre logique, la définition d’indicateurs pertinents (selon les critères SMART et CREAM), le choix de méthodes de S&E adaptées (distinguant suivi et évaluation, évaluation formative/sommative, participative, d’impact). Le module propose l’introduction explicite de l’apprentissage empirique pour compléter le suivi et l’évaluation traditionnels. Le module décrit également le piège de l’évaluation d’impact et son approche potentiellement trop étroite, au détriment du suivi continu et de l’apprentissage organisationnel nécessaires à l’amélioration des programmes.

Guides, manuels méthodologiques

- Evaluation handbook, DG INTPA, European Union, august 2024

Ce manuel de 2024 est le guide méthodologique de la Commission Européenne pour l’évaluation de ses actions extérieures. Remplaçant la version de 2006, il vise à standardiser et améliorer la qualité des évaluations en intégrant meilleures pratiques internationales et lignes directrices internes. Ce handbook détaille l’ensemble du processus d’évaluation, de la planification à la diffusion des résultats, en passant par la gestion, les approches méthodologiques, les outils de collecte et d’analyse de données, et les principes éthiques. Le critère spécifique « Valeur Ajoutée de l’UE » demande de vérifier si « l’intervention apporte des avantages supplémentaires par rapport à ce qui aurait résulté des seules interventions des États membres ». Le manuel propose de nombreux liens vers des outils récents pour la collecte de données via les TIC, l’analyse de données massives (big data) ou les approches géospatiales. L’approche interculturelle est présentée comme une modalité stratégique pour la réussite des évaluations.

En rupture avec le précédent guide, ce manuel acte le passage d’une vision linéaire de l’évaluation à une approche qui reconnaît et tente de gérer la complexité (théorie du changement, approches participatives, contextes de crise ).

Note du rédacteur :

Rédigé par des pointures de l’évaluation, les auteurs de ce manuel parviennent à synthétiser avec brio l’état de l’art de la discipline. Vous y trouverez de nombreuses ressources également référencées sur ce site, dont ils sont parfois les auteurs (Rick Davies, Patricia Rogers). Néanmoins, force est de constater qu’un manuel d’évaluation n’est qu’une brique dans le dispositif plus vaste que constitue le système de suivi et évaluation.

Par exemple, alors que le montant de l’aide couvert par ce manuel pourrait s’élever à près de 80 millards d’euros (Direction générale des partenariats internationaux , Direction générale du voisinage et des négociations d’élargissement, Service des instruments de politique étrangère), la base de donnée d’évaluations accessible au public contient, en juin 2025, 153 rapports uniquement, dont le document le plus récent date de juillet 2023 (voir bases de données).

Mais encore, pour évaluer, il faut tout d’abord s’accorder sur ce qu’on valorise. Le manuel expose ainsi succintement la vision politique de l’action extérieure de l’UE, puis dans le chapitre 4, entièrement consacré à l’éthique, les valeurs fondamentale de l’UE. A titre anecdotique (ou symptomatique ?), le manuel commence par ses mots : « Ce document ne doit pas être considéré comme représentatif de la position officielle de la Commission européenne. »

Comment une institution pourrait-elle guider l’évaluation de ses politiques les plus stratégiques sans participer à endosser officiellement la vision qui les guide et les apprécie ?

- Evaluation Handbook 2024, UNFPA

Un guide complet pour les évaluations décentralisées au sein du UNFPA, en particulier pour les évaluations de programmes de pays (CPE). Il met l’accent sur le renforcement des capacités en évaluation et vise à aider les responsables à appliquer une rigueur méthodologique systématique. Historiquement perçue comme une obligation administrative, l’évaluation tend à devenir un outil stratégique pour piloter la transformation interne et l’agilité organisationnelle. Le manuel propose une méthodologie d’analyse de contribution basée sur la théorie du changement, permettant d’évaluer comment les interventions du UNFPA influencent les résultats souhaités, même sans prouver une attribution directe. Le manuel recommande de limiter les questions d’évaluation d’un CPE à un nombre restreint de 6 à 8 questions clés pour garantir pertinence et utilité.

Comme les autres guides d’évaluation, ce manuel préconise d’intégrer l’évaluation dès la conception des programmes, de privilégier des méthodes mixtes et la triangulation des sources, d’impliquer les parties prenantes à chaque étape et de planifier la communication des résultats pour en maximiser l’impact. De manière moins commune, le guide met en avant une dimension de psychologique: la nécessité de garantir la sécurité et le bien-être des participants et des évaluateurs est une condition préalable fondamentale pour la validité éthique et la crédibilité méthodologique de l’évaluation

➡ une idée clé : co-créer les recommandations pour renforcer leur appropriation, néanmoins, la participation des gestionnaires de programme à la co-création des recommandations doit être strictement encadrée pour s’assurer que leurs propositions découlent directement des conclusions de l’évaluation et non de leurs propres désirs ou agendas

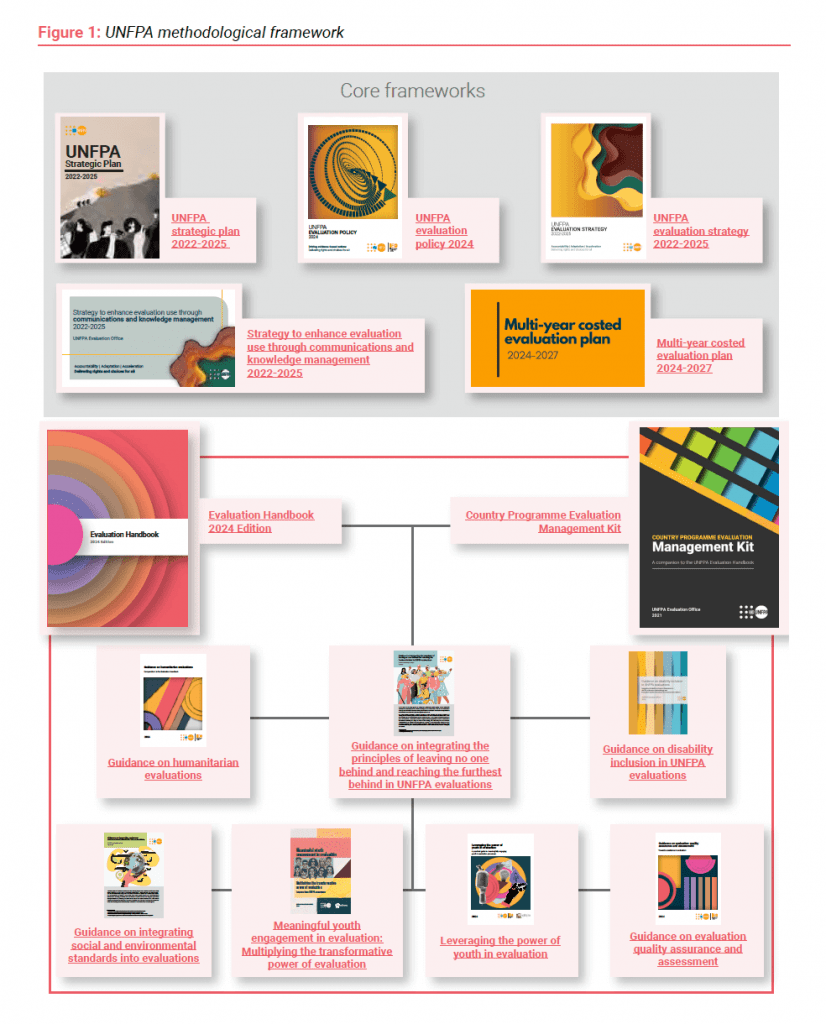

Le cadre méthodologique du UNFPA (Fonds des Nations Unies pour la Population) pour l’évaluation, structuré autour de plusieurs documents clés. Ce graphique expose comment différents guides et politiques s’articulent pour former une approche cohérente de l’évaluation au sein de l’organisation. Notamment : le Plan Stratégique du UNFPA 2022-2025, la Politique d’Évaluation du UNFPA 2024, la Stratégie d’Évaluation du UNFPA 2022-2025, la Stratégie pour renforcer l’utilisation de l’évaluation par la communication et la gestion des connaissances 2022-2025, le Plan d’évaluation pluriannuel chiffré 2024-2027.

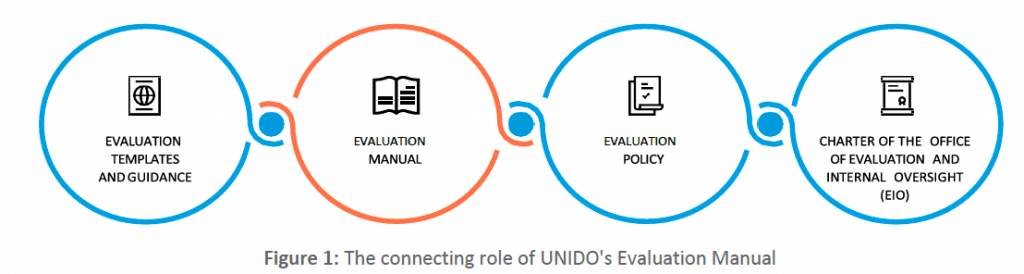

- UNIDO evaluation manual, revision, august 2024

Le manuel met en avant le rôle pivot de l’évaluation pour la prise de décision fondée sur des preuves, l’apprentissage organisationnel et la redevabilité. Le manuel intègre des « approches d’évaluation émergentes » comme la « Blue Marble Evaluation » et l’ « Inclusive Systemic Evaluation for Gender Equality, Environments & Marginalized Voices (ISE4GEMS) ». Ces approches visent à évaluer les transformations systémiques et à aller au-delà des cadres traditionnels, en reconnaissant la complexité et l’interconnexion des défis mondiaux. Ces variantes reconnaîssent que l’évaluation doit elle-même être transformée pour faire partie de la solution face aux crises mondiales. Le manuel, tout en soulignant l’indépendance de l’évaluation, insiste fortement sur son « utilité » et son « alignement » avec les priorités organisationnelles. L’évaluation, même indépendante, est avant tout un outil au service des objectifs stratégiques de l’UNIDO. Le manuel souligne que les projets pilotes peinent à être pérennisés s’il n’y a pas de planification de la généralisation, de la réplication et de la mise à l’échelle, ce qui est un défi récurrent dans l’aide au développement.

➡ une idée clé : se limiter à un l’évaluation de projets est myope ; il faut comprendre comment ces projets contribuent à des objectifs plus larges, des politiques ou des changements systémiques

- Manuel d’évaluation de l’UNESCO, janvier 2023

Ce manuel d’évaluation vise à fournir des conseils pratiques pour la planification, la gestion, l’assurance qualité et la supervision des évaluations. L’évaluation est présentée comme un pilier de la gestion axée sur les résultats. Les auteurs évoquent des défis persistants dans la mise en œuvre effective de l’évaluation avec une insistance sur la formation obligatoire et la désignation des points focaux pour de structurer et professionnaliser la fonction. Une tension demeure entre la théorie (principes directeurs, normes) et la pratique (besoin de guidance concrète, d’outils, de renforcement des capacités) que le manuel cherche a atténuer. En terme de ressources, une préconisation est d’allouer un budget minimal de 3% des dépenses de programme à l’évaluation. Depuis 2016, se déploie une opérationnalisation de Focaux pour l’Évaluation (PFE), désignés au sein d’une unité administrative (secteur, bureau hors Siège, institut) pour « aider le personnel de programme à assurer la planification, la gestion et l’assurance qualité des évaluations décentralisées ». Le guide préconise l’intégration des groupes prioritaires comme les jeunes et les peuples autochtones, dans la conception même des évaluations.

➡ une idée clé : adapter la gestion et la méthodologie de l’évaluation aux contextes de crise et aux contraintes imprévues, comme les pandémies, en privilégiant la sécurité et l’éthique avant la rigidité planificatrice.

Etude d’évaluabilité

- Guide pour le suivi et l’évaluation de projets/programmes, Fédération internationale des Sociétés de la Croix-Rouge et du Croissant-Rouge, 2011

La référence de l’époque en SE. Un guide pratique visant à harmoniser et améliorer les pratiques de suivi et d’évaluation (S&E) de la Fédération internationale des Sociétés de la Croix-Rouge et du Croissant-Rouge mais par extension à tout type de structure, même si celui-ci intègre spécifiquement les principes du mouvement (Humanité, impartialité, neutralité, indépendance, volontariat, unité et universalité). Le S&E est intégré dès la conception du projet pour une meilleure performance et redevabilité. Il insiste sur l’importance de la participation des parties prenantes, y compris les bénéficiaires, pour garantir la pertinence, la crédibilité et l’appropriation des informations. Le guide s’inscrit clairement dans le cadre de la « gestion axée sur les résultats » (GAR), qui met l’accent sur la mesure des performances, la redevabilité et l’apprentissage pour améliorer l’efficacité des interventions. Le guide offre en annexe divers canevas de tableaux directement opérationnel (tableau de suivi des indicateurs, calendrier de formation SE, fiche de poste SE,…)

➡ une idée clé : en analysant systématiquement les « variances » – les écarts entre ce qui était prévu (cibles) et ce qui a été réalisé (résultats réels) – les tableaux de suivi deviennent des outils d’apprentissage et de perfectionnement constant, bien au-delà de la simple conformité des résultats

- Le suivi-évaluation pour piloter, apprendre et rendre compte, GRET, Daniel Neu, 2011

Le suivi-évaluation doit être pensé en fonction de ses usages multiples (pilotage, reddition de comptes, apprentissage/capitalisation). Les dispositifs doivent être des ensembles d’outils complémentaires et évolutifs, incluant des mécanismes de discussion des informations. L’auteur critique les systèmes rigides et trop ambitieux basés sur de nombreux indicateurs « objectivement vérifiables » qui sont souvent difficiles à mettre en œuvre et peu utilisés. Le document suggère que l’aide au développement manque de mécanismes effectifs rendant les politiques de qualité parfois cosmétiques. Le S-E doit servir les acteurs du projet et être approprié par eux, plutôt que d’être une contrainte externe. Le S-E devrait activement servir de mécanisme pour « élargir l’horizon » du projet, le forcer à « s’exposer aux points de vue de tiers », et ainsi le rendre plus transparent et redevable au-delà de ses obligations contractuelles strictes.

➡ Une idée clé : l’efficacité du suivi-évaluation ne dépend pas principalement de la sophistication des outils ou du nombre d’indicateurs, mais de la capacité des acteurs à débattre des informations et à prendre du recul.

- Le suivi des interventions de développement, COTA asbl, Hédia Hadjaj-Castro, 2010

L’ouvrage aborde la complexité croissante du suivi des interventions de développement, notamment due à la multiplication des acteurs (locaux, Nord, bailleurs) et à l’évolution vers des approches programmes. Il critique les dispositifs de suivi trop linéaires, souvent réduits à des systèmes de collecte d’information axés sur le cadre logique et les indicateurs quantitatifs, négligeant la diversité des perspectives.

La conception d’un dispositif de suivi doit être itérative, flexible et adaptée aux ressources et capacités, en privilégiant les questions-clés pertinentes pour les acteurs, comme base du dispositif, avant de se focaliser sur les indicateurs. Le suivi n’est pas un processus neutre, mais un lieu où se jouent des relations de pouvoir. Qui définit quoi suivre, pour qui, et comment les informations sont utilisées, sont des questions éminemment stratégiques. Les interventions de développement sont complexes et les modèles linéaires (comme la chaîne de résultats) ne suffisent pas à en capter la richesse et les dynamiques imprévues.

- Trousse à outils de l’Administrateur de Programme pour la Planification, le Suivi et l’Evaluation – UNFPA, 2004

Ce guide est destiné aux administrateurs de programmes du FNUAP pour intégrer la planification, le suivi et l’évaluation dans une gestion axée sur les résultats. Le document articule l’évaluation autour de deux piliers : l’apprentissage organisationnel (comprendre pourquoi un projet réussit ou échoue) et l’exercice des responsabilités (rendre des comptes aux donateurs et partenaires). Il distingue clairement trois fonctions : le suivi (continu, pour piloter), l’évaluation (périodique, pour juger de la valeur et apprendre) et l’audit (pour vérifier la conformité financière et réglementaire). Le document ne présente pas l’évaluation comme un exercice académique ou une simple formalité de fin de projet, mais comme un outil de gestion dynamique et intégré à toutes les étapes du cycle de programme. le passage d’une culture de la justification des moyens à une culture de la preuve des résultats. Auparavant, le succès se mesurait souvent à la bonne exécution des activités planifiées et au respect du budget (logique d’audit). Ce document pousse à une rupture en exigeant de répondre à des questions plus difficiles : « Le programme était-il pertinent ? », « Quels effets a-t-il eus ? », « Pourquoi cela a-t-il fonctionné ? ».

Guides sous l’intitulé spécifique MEAL ou MEL (Monitoring, Evaluation, Accountability, Learning – Monitoring, Evaluation, Learning)

- 2021 – Manuel Suivi, évaluation, responsabilisation et apprentissage (MEAL)

Standards, Pratiques et Conseils Techniques, International Rescue Committee

Cette actualisation des guides antérieurs, vise une harmonisation des pratiques de Suivi, Évaluation, Redevabilité et Apprentissage (MEAL) au sein de l’IRC. L’intégration explicite des retours clients tout au long du cycle de vie du projet est un élément central afin de conduire à des interventions mieux ciblées. Lorsqu’une évaluation externe est commanditée, l’équipe de programme décide des objectifs, tandis que l’équipe MEAL apporte un soutien technique substantiel sur des aspects tels que la rédaction des Termes de Référence (TdR), le budget et la méthodologie. Les conseillers techniques et les coordinateurs régionaux doivent approuver les TdR avant de démarrer le processus d’évaluation. Une recommandation est de toujours partir des données déjà disponibles afin de ne pas générer une lassitude de la part des répondants. Mais aussi la saisie systématique et régulière des données MEAL dans la base de données, illustrant les difficultés concrètes de terrain, une fois l’architecture du système précisé de lui donner réellement vie tout au long des activités opérationnelles. Contraintes de temps, manque de formation ou de motivation, problèmes matériels ou de connectivité,… Nous notons que les bénéficiaires de l’aide sont désormais appelés des clients, ceci afin de « mettre en avant notre conviction que les personnes que nous servons ont le droit de décider du type d’aide et de services dont elles ont besoin et qu’elles veulent ».

Ce document est intéressant car il clarifie la répartition des rôles et responsabilités entre les équipes de direction et les équipes MEAL.

- 2020 – Suivi, évaluation, apprentissage : concepts, principes et outils, Agrinatura, FAO

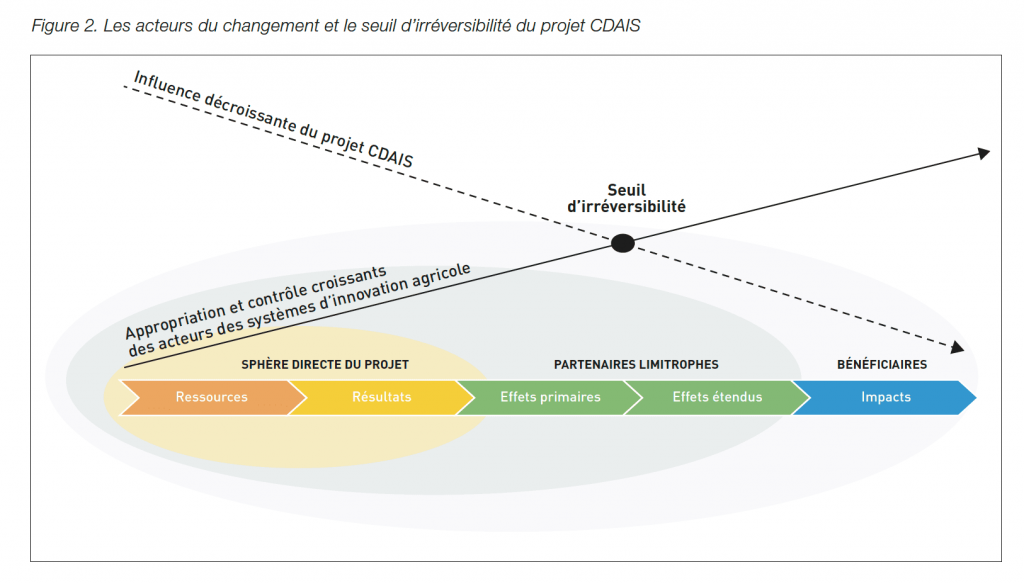

Ce document présente le cadre, les objectifs, les principes et les outils du système de Suivi, Évaluation et Apprentissage (SEA) du projet de Renforcement des capacités pour les Systèmes d’innovation agricole (CDAIS). Mis en œuvre dans huit pays pilotes, ce système visait à soutenir l’exécution du projet et à prouver les changements induits, en se concentrant sur le renforcement des capacités fonctionnelles des acteurs à différents niveaux (individuel, organisationnel, systémique). Il s’appuie sur une approche participative et adaptative, utilisant des outils comme la cartographie des incidences pour favoriser le développement des stratégies d’intervention ou l’évaluation réaliste cherchant à comprendre les mécanismes de changement dans des contextes variés.

Le retour d’expérience évoque une adhésion non immédiate des équipes nationales, un apprentissage progressif et un accompagnement soutenu, un investissement en formation et une modification des cultures opérationnelles. Le succès de l’implémentation du SEA est fortement lié à la présence et à l’implication continue de points focaux dédiés.

La notion de seuil d’irréversibilité est présentée. Ce terme désigne le moment où l’appropriation des nouvelles approches et la prise de contrôle par les acteurs au sein du système d’innovation agricole sont si complètes qu’un retour à l’état antérieur ne semble plus envisageable. Le projet a « décollé » et vole de ses propres ailes.

- 2019 – Guide du MEAL – D Pro – suivi, évaluation, redevabilité et apprentissage pour les professionnels du développement, CRS, Humentum

Ce guide propose une méthode pas à pas pour intégrer le Suivi, l’Évaluation, la Redevabilité et l’Apprentissage (MEAL) dans les projets de développement et humanitaires, ciblant les professionnels non-spécialistes. Il détaille la conception de différents types de modélisations, la définition des indicateurs, la planification du MEAL. Le guide couvre également la collecte, l’analyse et l’utilisation des données pour une gestion adaptative. L’accent est mis sur des outils pratiques, l’éthique, la participation des parties prenantes et la réflexion critique. Le MEAL est présenté comme un système intégré (puzzle), un cycle continu qui implique la responsabilité de toute l’équipe de projet, pas seulement des spécialistes. Il conteste la vision d’un MEAL uniquement destiné aux bailleurs, promouvant une redevabilité élargie aux communautés et autres parties prenantes. Le guide suggère que le MEAL est souvent sous-financé, mal compris ou mis en œuvre de manière lacunaire. L’insistance sur la gestion adaptative et l’apprentissage trahit une certaine reconnaissance que les projets peinent à tirer les leçons de leurs expériences et à s’ajuster aux contextes changeants.

- 2015 – Monitoring, evaluation and learning system review, International Rescue Commity, Nigel Simister

Ce rapport de Nigel Simister examine le projet triennal (2013-2015) de renforcement des processus de suivi, évaluation et apprentissage (MEL) au sein du Conseil Danois pour les Réfugiés (DRC). L’objectif était d’évaluer les progrès réalisés dans la mise en place de dispositif MEL pour une cohérence globale au niveau international. La revue est basée sur une analyse documentaire, des entretiens avec le personnel du siège et des entretiens plus larges avec divers employés de DRC.

Des progrès substantiels ont été réalisés, notamment avec l’introduction de Procédures Opérationnelles Minimales MEL (MELMOPs). Egalement, l’introduction des Revues en Temps Réel (RTR) sont considérées comme un grand pas en avant. Il existe une volonté de dépasser un reporting basé sur les activités pour tendre vers un suivi évaluation stratégique axé sur des plans stratégiques triennaux. Pour se faire, il est nécessaire de « désapprendre » d’anciennes pratiques en même temps qu’elle en apprend de nouvelles. Il existe un décalage notable entre les ambitions du siège pour un système MEL global et standardisé, et la capacité ou la volonté d’absorption au niveau du terrain.

En terme de limite, il est souligner une absence de dispositif permettant d’agréger les résultats au niveau mondial. Que les outils et procédures seuls ne suffisent pas avec un seul conseiller MEL au niveau du siège, pour porter seul cette transformation ; des ressources, un mandat et une volonté institutionnelle forte est nécessaire. Enfin, l’auteur laisse percevoir un manque de recul critique sur l’effectivité réelle du système.

- 2011 – Making evaluations matter: A practical guide for evaluators, Kusters, C.S.L. et al.

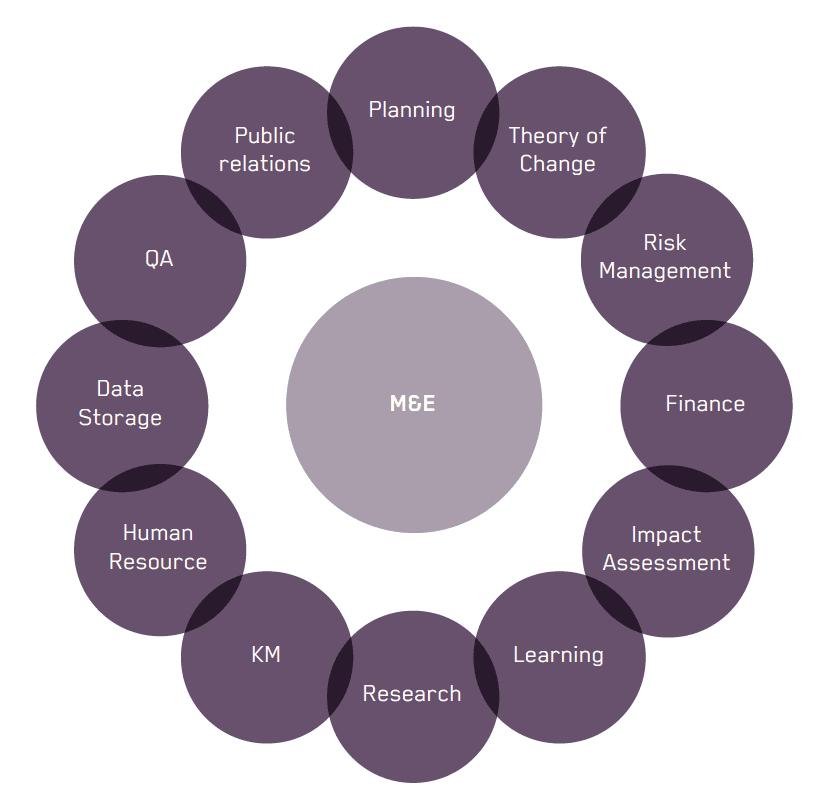

Trop souvent les rapports d’évaluation prennent la poussière, très peu étant fait pour accompagner le changement auprès des parties prenantes à l’origine de la démarche d’évaluation. L’évaluateur doit adopter divers rôles (facilitateur, formateur, analyste, agent de changement, etc.) en fonction des besoins de l’évaluation et des parties prenantes. Ce guide s’adresse en premier lieu aux évaluateurs actifs dans le champs du développement international. Il sera aussi utile aux commanditaires de l’évaluation et tout professionnel de l’évaluation. Ce guide s’attache à maximiser l’utilité de la fonction d’évaluation. Enfin il propose d’évaluer l’évaluation : Réfléchir de manière critique au processus d’évaluation lui-même et à ses résultats afin d’améliorer les pratiques futures.

Programmes de subventions

- Setting new standards for better MEL, Lessons for grantees & funders, M. Colnar, A. Azevedo, C. Tolmie, and H.Caddick, November 2022

Pour aller plus loin :

- les étapes de mise en place d’un SSE – sommaire

- Du SE au SERA (from M&E to MEAL)

- Manuel de suivi évaluation : par organisations