Nous évoquerons ici l’environnement dans le sens de cadre, de contexte.

Aussi bien le contexte institutionnel (les normes établies, les valeurs, les modes de gouvernance,…) que les contextes pragmatiques tels que présentés par Jean-Pierre Olivier de Sardan1 : les jeux d’acteurs, les normes et pratiques, les routines, les logiques de contournement… Ou encore les attitudes et les manières d’agir : les valeurs et vulnérabilités des individus influencent leurs comportements au sein des équipes.

Et « propice » dans le sens de favorable, en anglais « enabling environment » : habilitant ou déclencheur, un environnement qui favorise, qui permette l’évaluation.

La montée en compétences des systèmes de suivi et évaluation au niveau des programmes et des projets

Depuis une quinzaine d’années, nous avons pu assister à la structuration de systèmes de suivi et évaluation au niveau des institutions et plus particulièrement au niveau des programmes et des projets, notamment grâce à des lignes budgétaires appropriées et des postes spécifiques dédiés.

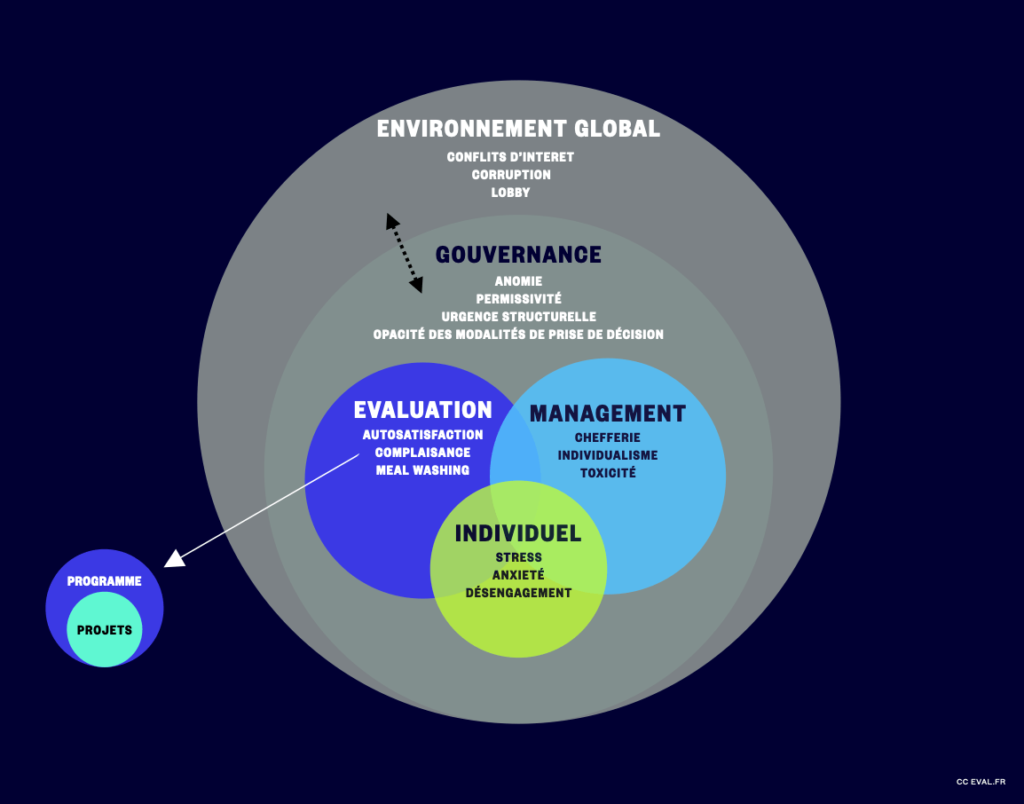

Néanmoins, ces unités de suivi et évaluation naviguent dans des environnements complexes que nous allons ici noircir à dessein : le principe étant que si un seul des dysfonctionnements présentés ci-dessous est activé/toléré, c’est l’ensemble du système de suivi et évaluation qui se trouve annihilé.

Au niveau organisationnel, l’évaluation est plus ou moins bien structurée au niveau des programmes et des projets. L’évaluation porte alors généralement sur un certain nombre de critères de référence, c’est-à-dire les critères du CAD : pertinence, cohérence, efficacité, efficience, impact, durabilité. Ces évaluations sont susceptibles de passer à côté de dysfonctionnements dans les modes de management ou de gouvernance des organisations qui portent le projet. Mais encore se limiter à constater des répercussions sur les projets liées à des dynamiques inconnues au simple niveau de l’action évaluée, des causes invisibles et indécelables. Par exemple l’intervention de lobbies, des clientélismes, de la corruption, de la prise illégale d’intérêt, etc.

A quel moment une évaluation de fin de projet « standard » est-elle en position de détecter et surtout en capacité d’agir sur des problématiques de conflits d’intérêt, de traçabilité des processus décisionnels, de management toxique, de désengagement des personnels ? L’évaluation de projet est-elle coordonnée pour que des interactions existent avec une évaluation indépendante, au niveau de l’institution comme de l’évaluation de politiques publiques ?

Selon l’expression, les cordonniers étant souvent les plus mal chaussés, commençons par les cellules/unités/départements évaluation. Au-delà des potentiels biais et difficultés techniques, nous observons des défis, cadres ou contextes où existent : des unités d’évaluation marginalisées, de la complaisance au regard des programmes, du MEAL washing, de l’autosatisfaction, du suivi à des fins de contrôle uniquement, des évaluations inutiles car non exploitées, de la rétention d’information, une certaine opacité…

Ces unités s’inscrivent dans un style de management impulsé et décliné par l’institution sur l’ensemble des unités où peuvent exister : des chefferies ou seigneuries, un climat de défiance, de la toxicité, de la déconsidération, de l’individualisme, de la condescendance, de l’intimidation, de l’irrespect, du sexisme, de forts turn-overs.

Chaque unité (projet,équipe,…) étant composée de personnalités individuelles avec des répercussions distinctes en termes de stress, d’anxiété, de désengagement. A l’origine, au-delà des techniques de management, des égocentrismes, de la mégalomanie, du narcissisme et des comportements toxiques tolérés.

Tout ceci s’insère dans des modes de gouvernance institutionnelle plus globaux où nous pourrons retrouver de l’anomie (disparition des valeurs communes à un groupe), une forte inertie malgré un fonctionnement permanent en mode urgence, une certaine permissivité, une opacité des processus décisionnels,…

Ceci dans un cadre où les pays disposant d’une évaluation institutionnalisée sont encore rares : voir quelques exemples sur la page gouvernance de l’évaluation/institutionnalisation de l’évaluation.

Concomitamment, les institutions publiques évoluent dans des environnements nationaux et internationaux où coexistent de manière plus ou moins prononcés divers enjeux tels que les conflits d’intérêts, la concussion, la corruption, le favoritisme, les lobbys, la prise illégale d’intérêt, le trafic d’influence, le clientélisme, l’autoritarisme et le régionalisme.

De nouveau, il ne s’agit pas ici d’exposer un cadre existant, mais la capacité de détection d’une seule de ces occurrences, susceptible de rendre inopérant l’intégralité du système de SE que nous nous évertuons à mettre en œuvre.

Les projets et programmes d’intérêt général seront scrutés au regard de leur performance quand bien même parallèlement aucune donnée ne reflètera les sources de dysfonctionnement plus profondes qui sortent du champ de l’évaluation stricte du projet.

Dans le meilleur des cas, nous aurons des projets « bien évalués » : au regard de leur pertinence, cohérence, efficacité, efficience, de leur impact et de leur durabilité.

Agrandir le champ de vision de l’évaluation au-delà des programmes et projets

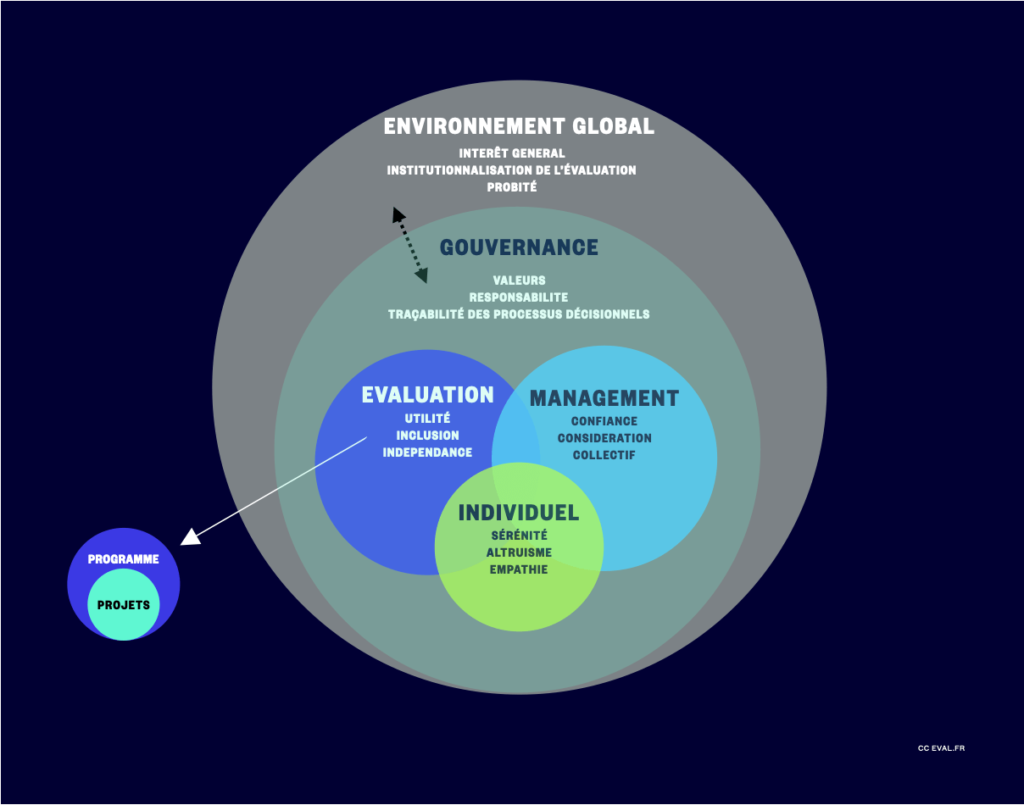

Essayons de trouver le miroir des dysfonctionnements précédemment cités :

- Au niveau d’un service/unité/département d’évaluation : utilité, inclusion, transparence, circulation de l’information,…

- Au niveau individuel/des qualités personnelles et humaines : solidarité, empathie, dévouement, équilibre, loyauté, adaptabilité, esprit d’équipe…

- Au niveau du management : collectif, respect, valorisation, engagement, considération, confiance, stabilité, progression, cordialité,…

- Au niveau de la gouvernance institutionnelle : valeurs, vision, probité, responsabilité, conformité, traçabilité des processus décisionnels,…

- Au niveau de l’environnement global : éthique, intérêt général, institutionnalisation de l’évaluation

La démarche est décevante puisque rien de bien nouveau dans la figure ci-dessus, nous avons simplement retrouvé les normes et principes d’évaluation tels que présentés dans les cadres internationaux de la discipline. Des valeurs déclinées au fil des pages de tout rapport institutionnel.

Néanmoins, a minima 3 constats :

- Les évaluations de projets n’ont pas à se prononcer systématiquement sur leur environnement, favorables ou non, propices ou non, par exemple exposer et expliciter d’éventuels conflits d’intérêt.

- les évaluations de projets s’inscrivent majoritairement dans les critères du CAD, certaines valeurs ou critères alternatifs sont alors hors champ de vision : la collaboration, la relation de confiance, la solidarité, l’engagement, l’esprit d’équipe, la prise de risque, …

- Les équipes d’évaluation peuvent se retrouver totalement démunies face à tout ce qui interroge la probité : en tant que simples prestataires de service, consultants, quel devrait être leur interlocuteur ?

Pourtant, nous avons au niveau de l’évaluation de projets et programmes un réservoir de compétences fantastiques, au service de l’institutionnalisation de l’évaluation.

Trois propositions à ce stade :

- insérer systématiquement dans toute évaluation une partie liée à l’analyse du contexte propice ou non à l’évaluation

- dépasser les critères du CAD : hiérarchiser les critères en fonction des priorités exprimées localement, intégrer des critères plus spécifiques (par exemple l’appropriation) mais parfois aussi basiques et de bon sens (par exemple les capacités de gestion)

- des protocoles stricts et éclairs doivent être déclenchés et pilotés par l’institution qui porte le projet pour toute question émise par un.e chargé.e de suivi évaluation (expert.e SE, responsable SE,…) interrogeant des principes d’évaluation ou la probité

Pour aller plus loin

- Un environnement propice à l’évaluation

- Un environnement propice à l’évaluation : quels leviers ?

- Glossaire : principes, normes, standards d’évaluation

- Glossaire : éthique, déontologie, intégrité

- Ethique, déontologie, intégrité : quels mécanismes et outils ?

- Jean-Pierre Olivier de Sardan, La revanche des contextes. Des mésaventures de l’ingénierie sociale, en Afrique et au-delà, Paris, Karthala, coll. « Hommes et sociétés », 2021, 494 p. ↩︎

Date de première diffusion : juillet 2023

Date d’actualisation : juin 2024