En terme de qualité des données, l’enjeu principal est la fiabilité.

La fiabilité d’une donnée repose sur son exactitude, le degré de confiance qu’elle génère, sa capacité à exprimer ou reproduire fidèlement une information brute.

Un regard cru sur les limites et faiblesses de tout jeu de données est ainsi nécessaire et complémentaire à son utilisation.

Le constat brut et admis d’une absence de données est bien sûr préférable au risque de prise de décision sur fondement de données invalides. D’un constat sans appel d’une absence de données nait par ailleurs une démarche réflexive sur la mise à jour du système de suivi et évaluation à partir du constat et de l’affichage de ses dysfonctionnements.

Comme pour détecter les biais, les considérations à apporter à la validité des données devraient être aussi conséquentes que celles dédiées à la collecte et au traitement des données.

La prise en compte de la qualité des données repose sur une multitude de critères et considérations :

Temporalité (fraicheur, actualisation, disponibilité)

L’information est la denrée qui périme le plus vite. Le journal de la veille se transforme en invendu dès la parution de l’édition du jour. De la même manière, rapports hebdomadaires ou mensuels bénéficieront d’une fenêtre de lecture et d’utilité limitée à leur cycle. Statique ou dormante, la donnée devient ultérieurement sans utilisation une simple charge (classement, stockage,…).

Standardisation

Est-ce que le mode de calcul d’un même indicateur est strictement identique d’un projet à l’autre ?

Conformité

Est-ce que les procédures de collecte et de traitement des données correspondent aux standards définis dans le plan de suivi et évaluation ? Bien sûr cette conformité ne peut être estimée que si un manuel ou une référence interne est préalablement existante…

Conformité externe également au regard de normes ou de réglementation en terme de sécurité, de stockage, de traitement de données personnelles.

Traçabilité

L’impératif de pouvoir identifier l’origine et le parcours de toute donnée. Définir les rôles et responsabilités à chaque étape.

Unicité

Chaque donnée est unique, un nettoyage régulier des bases de données doit permettre d’éviter les doublons. Par exemple un même usager d’un service enregistré sur différentes adresses.

Cohérence

Savoir détecter des valeurs aberrantes permet un contrôle de cohérence. Des valeurs incongrues ou extrêmes (âge : 145 ans !) peuvent être dues à une erreur de saisie ou encore à une mauvaise compréhension/explication d’une question par l’enquêteur (par exemple sollicitation du revenu mensuel au lieu du revenu annuel). Le contrôle de cohérence s’intègre directement au questionnaire, via les valeurs de champs par exemple, puis nécessite l’interprétation « humaine » des données par les analystes ou utilisateurs.

Complétude

Est-que des données sont manquantes ? Est-ce un problème de retard ? D’accès aux données ? A quel point ce vide compromet-il la justesse de la vision d’ensemble ?

Comparabilité

En interne : l’enjeu de croiser les données, d’homogénéisation des pratiques, des outils, des bases de données d’indicateurs afin de compiler ou comparer les actions, projets, programmes, politiques publiques.

En externe : favoriser une comparabilité au niveau international, entre régions, pays, collectivités ou entre structures, sur la base de jeux d’indicateurs existants comme les Objectifs de Développement Durable.

Confidentialité

Au delà des aspects légaux, à quel point les enjeux liées à la confidentialité des données traitées sont considérées et actualisées ?

Les répondants, en vous accordant leur confiance vous transmettent des informations pouvant se révéler confidentielles, c’est à dire à usage restreint. Quels mesures ou codes de conduite éthique ou déontologique permettent de garantir cette confiance ?

Contrôle et lutte contre la fraude

Toute manifestation délibérée de tromperie, de falsification des données (ou de dissimulation de données) devrait être liée à une procédure de signalement en interne liée au code déontologique.

Gouvernance des données

Les critères présentés ci-dessus s’intéressent spécifiquement à la phase de collecte et de traitement des données.

Comme à l’accoutumée dans la sélection de critères d’évaluation, l’intérêt est de croiser leurs analyses. C’est à dire varier les angles à travers une diversité de critères. Par exemple si des données sont absentes, est-il encore temps et pertinent de les collecter (complétude + temporalité) ?

Bien sûr, il ne faudra pas perdre de vue la vision globale de la mise en place du système de suivi et évaluation. Notamment en terme d’exhaustivité des données : la capacité à illustrer l’ensemble du périmètre sélectionné (voir étape 2 : les champs du système) en fonction du volume global de données collectées et mises à disposition.

Egalement considérer la lisibilité et interprétabilité des données : est-ce que le format est adapté et compréhensible par les utilisateurs clés ? Les formats de présentation et notamment les échelles ne devraient laisser place à aucune ambiguïté.

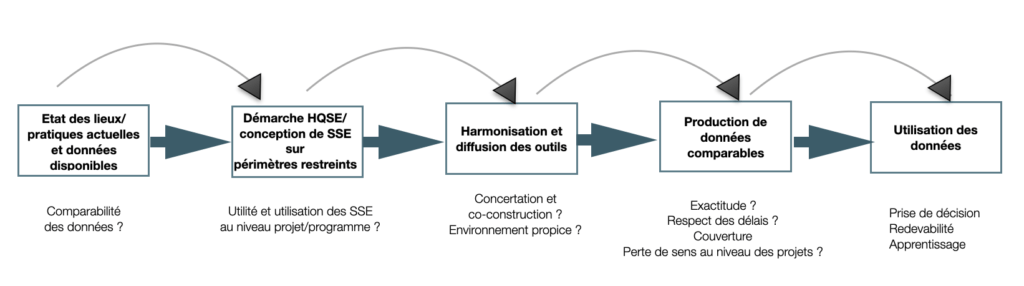

Le contrôle qualité des données est ainsi à considérer dans un cycle de collecte et d’utilisation des données, partie intégrante du Système de Suivi et Evaluation.

Lectures complémentaires

- Field Guide for Data Quality Management, Monitoring, Evaluation, Results and Learning Series Publications, Module 2, PACT, 2014

Pour aller plus loin

Etape 4 : planifier la collecte d’information et et le traitement des données

➡ Tableaux de suivi des indicateurs

➡ Seuil de déclenchement

➡ Suivi des activités

➡ veille documentaire et sources d’information

➡ observation

➡ entretiens

➡ focus group

➡ enquête par questionnaires

- Contrôle qualité des données

- Biais et points de vigilance

- La protection des données personnelles

- Plateformes de suivi, évaluation, apprentissage

Date de première diffusion : 2020

Dernière actualisation : juillet 2023