Un biais, peut être statistique, une erreur dans la méthodologie de l’étude ou encore cognitif, une distorsion dans le traitement puis l’analyse d’une information, consciente ou inconsciente.

La présentation des multiples sources de biais est très technique mais leurs conséquences sont très pragmatiques et affectent la qualité d’une démarche d’évaluation :

- induire en erreur la prise de décision en se fondant sur des informations tronquées (fonction d’aide à la décision de l’évaluation)

- légitimer des échecs en les faisant passer pour des succès (fonction de transparence et reddition de comptes de l’évaluation)

Les formats de rapportage dans les projets et programmes sont souvent imposants et chronophages, limitant le temps d’implication pour un regard critique sur la qualité du format en place.

Pourtant il faudrait fournir autant d’énergie à traquer les biais qu’à collecter les données.

Ci-dessous, différents biais fréquemment rencontrés dans l’évaluation de projets, programmes ou politiques publiques.

Biais de sélection/représentativité

➡ les personnes interrogées ne sont pas représentatives de la population visée

Est-ce qu’une population cible a été déterminée en amont ?

Ce biais questionne la sélection des répondants dans le temps et dans l’espace. Quelle est la périodicité du suivi ? Est-ce que l’échantillon retenu est interrogé sur toute la durée du cycle de projet ?

Est-ce que l’enquête sera menée sur l’ensemble de la zone géographique visée ? Est-ce que le questionnaire sera distribué sur le lieu d’intervention uniquement (par exemple un centre de soin) mais aussi d’autres espaces où le service n’est pas présent ?

Biais de mesure

➡ les techniques de mesure sont incorrectes

- En fonction de l’outil : la palette de réponses ne correspond pas à la réalité du répondant, des questions sont imprécises, la traduction laisse à désirer, les volumes ou échelles de grandeurs sont imprécis ou inadaptés.

Par exemple : sous la bannière « nombre de personnes formées » sont comptabilisées aussi bien des stagiaires ayant intégré un atelier de 2 heures de sensibilisation que d’autres ayant finalisé un cursus diplômant de 420 heures…

- En fonction de l’enquêteur : tous les répondants ne sont pas mis dans les mêmes conditions d’enquête (temps de passation disparates, niveaux d’accueil et de confort distincts, présentation de l’étude aléatoire,…), des questions incomprises, des items sautés, une adaptation du questionnaire au temps disponible ou à l’attitude du répondant (« je dois partir dans 2 minutes » indique l’interviewé – « d’accord j’accélère » répond l’enquêteur, etc.)

➡ Biais d’analyse ou d’interprétation

Les données sont davantage mises en valeur lorsqu’elles arrangent leurs auteurs. C’est pourquoi les rapports annuels ou rapports d’activités ne sont qu’une litanie de réussites exemplaires.

Cette caractéristique engendre de nombreuses distorsions dans la fonction même de l’évaluation car de données brutes et exactes pourront surgir des interprétations diverses. D’où l’intérêt de s’accorder en amont sur les valeurs qui sous-tendent une action ou un programme.

- Biais d’auto-complaisance : une tendance à s’attribuer les réussites mais blâmer le contexte extérieur pour les échecs

S’ajoute la notion de responsabilité, notamment dans la conduite d’une action publique : endosser une importante responsabilité pour les résultats souhaitables et réduire sa responsabilité pour des résultats non souhaitables.

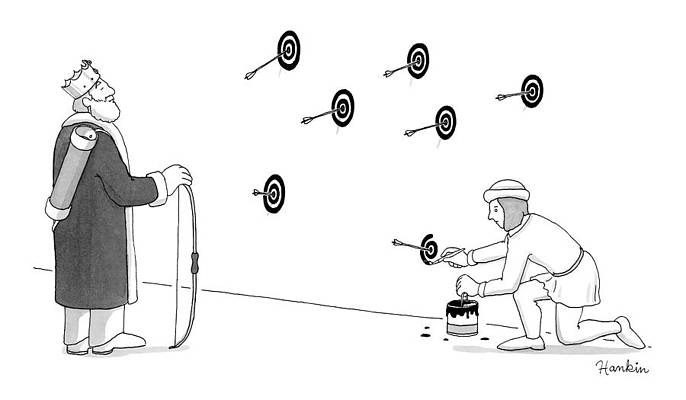

Sans cadrage préalable sur les valeurs (ou de manière plus prosaïque si le système de suivi évaluation n’est pas opérationnel au démarrage de l’action), le monarque pourra orienter à sa guise la collecte de données pour en extraire ce qui le met en valeur.

Exemple

Dans cette étude de base réalisée dans le cadre d’un programme de lutte contre les pires formes de travail des enfants, nous apprenons que dans le département de San Miguel, El Salvador, le travail des enfants concernerait pour 83,3% des garçons et 16,7% des filles.

Une donnée incontournable, parmi d’autres, comme la répartition par âge ou par type d’activité afin de construire le programme et permettre aux acteurs publics de proposer des mesures afin de contribuer à l’éradication des pires formes de travail des enfants.

Oui, mais quel était l’échantillon ? Est-il représentatif de la population du département et suffisamment conséquent pour refléter les variables socio-démographiques des enfants affectés ?

Douze ! Uniquement 12 enfants ont été interrogés à l’échelle de la ville de San Miguel, ce qui ne saurait être représentatif ni de la ville ni d’un département. Au moins un élément de l’étude de base se relève biaisé et non valide.

Prendre connaissance de la méthodologie de l’étude est ainsi un préalable indispensable à toute impulsion d’analyse ou d’interprétation des données.

Conflits d’intérêt

Des informations peuvent être tronquées en fonction des enjeux réels ou supposés, sur les intérêts individuels et collectifs des répondants.

En phase d’étude initiale des besoins et des attentes : le répondant pourra avoir tendance à magnifier l’ampleur de la problématique rencontrée dans l’espoir d’une prise en charge par l’opérateur ou le bailleur.

En phase finale, l’opérateur de mise en oeuvre cherche à éclairer ses résultats. Or, si les objectifs ont été atteints, une problématique atténuée, une conséquence pourra être le tarissement du financement. A l’inverse, de résultats non-atteints et de problématiques qui persistent, pourront découler un renouvellement de l’aide.

L’analyste doit ainsi apprécier à quel point certains facteurs sont susceptibles d’affecter l’objectivité ou la neutralité des répondants.

Lecture complémentaire :

Une nouvelle : Magic Number 8

Dans les coulisses d’un recensement de population au Nigeria.

En bref

Un biais, dans le contexte de l’évaluation de projets ou de politiques publiques, désigne une erreur méthodologique ou cognitive qui fausse la collecte, l’analyse ou l’interprétation des données, souvent de façon inconscient. Ces biais peuvent influencer la prise de décision ou masquer des échecs en les présentant comme des succès. Parmi les biais fréquents figurent le biais de sélection, où les personnes interrogées ne représentent pas la population cible, comme des biais divers liés à la méthodologie ou à l’interprétation des résultats. Pour garantir la qualité et la fiabilité des évaluations, il est essentiel de consacrer autant d’efforts à l’identification et à la limitation des biais qu’à une recherche toujours plus exhaustive de données.

Pour aller plus loin

Etape 4 : planifier la collecte d’information et le traitement des données

➡ Tableaux de suivi des indicateurs

➡ Seuil de déclenchement

➡ Suivi des activités

➡ veille documentaire et sources d’information

➡ observation

➡ entretiens

➡ focus group

➡ enquête par questionnaires

- Contrôle qualité des données

- Biais et points de vigilance

- La protection des données personnelles

- Plateformes de suivi, évaluation, apprentissage

Date de première diffusion : 2020

Dernière actualisation : janvier 2023