« La finalité d’un système est ce qu’il produit, pas ce qu’il prétend produire. Il n’y a, après tout, aucun sens à affirmer que la finalité d’un système est de faire ce qu’il échoue constamment à faire. »

Stafford Beer

Dans un système de suivi et évaluation comme dans tout système, un seul lien est manquant, un seul composant est défaillant, un seul dispositif de prise de décision inefficace, ou encore un seul délai de réponse trop lent et c’est l’ensemble du système qui risque de se révéler inutile et inopérant.

Nous reviendrons au fil des pages suivantes sur la diversité et multiplicité des facettes et considérations à intégrer dans la conception d’un système de suivi et évaluation.

Mais concentrons nous ici tout d’abord sur diverses causes fréquentes de mise en échec de systèmes, issues d’expériences de terrain, afin de mieux pouvoir anticiper, appréhender et éviter ces dysfonctionnements.

Chaque projet ou programme étant spécifique, avec un ancrage institutionnel de l’évaluation qui lui est propre, l’énumération ci-dessous n’est en aucun cas exhaustive et ne demande qu’à être complétée. Certains points de dysfonctionnement pourrons apparaitre comme des erreurs de jeunesse dans des systèmes balbutiants. Mais aussi comme des lignes jaunes infranchissables dans des organisations ayant déjà une culture évaluative ou une gouvernance plus élaborée. Ou enfin soulever des questions d’ordre éthique ou déontologique. L’intérêt étant de reprendre une approche systémique afin que chacun puisse interroger certains aspects structurels comme fonctionnels de leur système de suivi évaluation, notamment la qualité des composantes et la qualité des interrelations.

Dysfonction 1

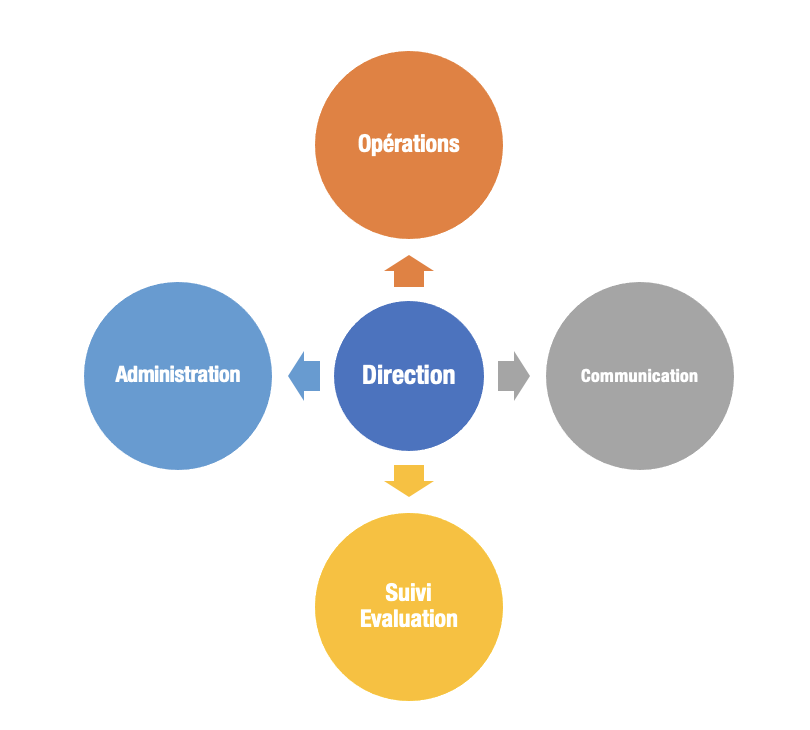

Positionnement du Suivi Evaluation dans l’organigramme

Cas de figure :

Le responsable Suivi Evaluation est sous l’autorité directe et unique de la direction d’un programme. Les liens avec la cellule ou division Suivi Evaluation sont très distendus. Parallèlement, aucune instance d’évaluation indépendante n’est en place.

Conséquences : il s’agit ici du far west de l’évaluation. En cas d’appétence de l’équipe de direction pour la discipline de évaluation, cette configuration peut donner de très beaux résultats avec des systèmes authentiquement conçus sur mesure. Mais si ce n’est pas le cas, l’équipe de direction se trouve toute puissante :

- marginalisation de la fonction Suivi Evaluation

- sélection des seuls indicateurs qui mettent en valeur le programme

Si les personnes en position d’autorité (« princes ») ne revendiquent pas ouvertement ce pouvoir arbitraire et tiennent un double langage en mettant en valeur l’évaluation dans les discours officiels, les défauts du système aboutissent aux mêmes résultats : des décisions prises sans justification appropriée ou sans tenir compte des données objectives.

A titre de comparaison, comme si un comptable n’était pas soumis à des règles comptables, c’est à dire des normes et principes de comptabilité générale fixées à un niveau national ou international, mais uniquement dépositaire de cahiers de vacances facultatifs en suivi et évaluation, modifiables au bon vouloir de la direction du programme.

Pistes d’amélioration :

- composition d’un groupe de travail Suivi Evaluation au sein du comité de pilotage

- validation du système de Suivi Evaluation par le comité de pilotage

Préalable :

- politique de Suivi Evaluation définie et déployée

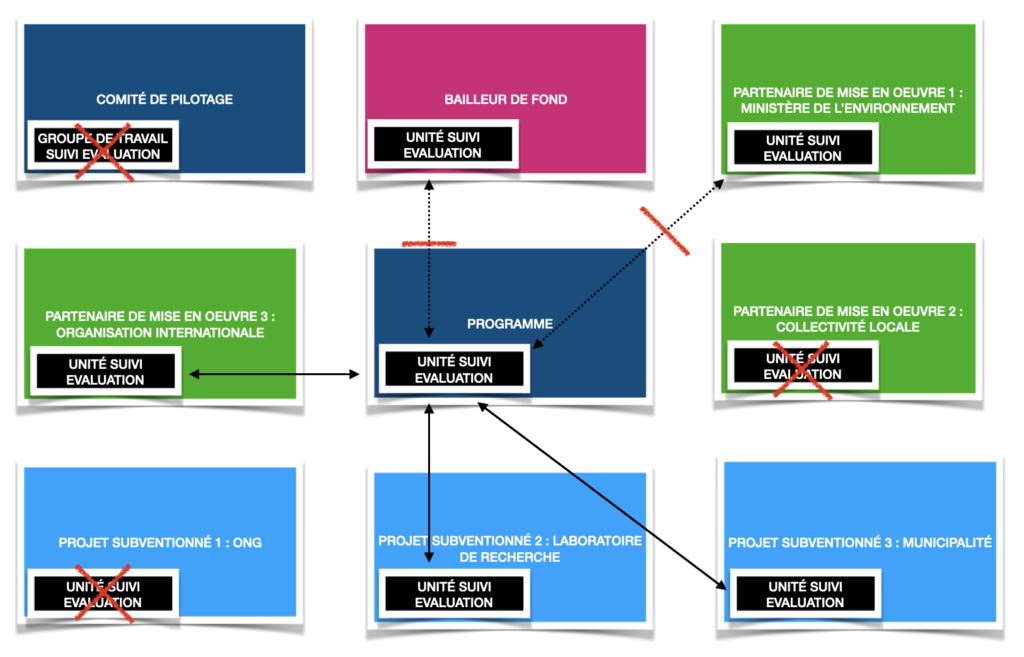

Il s’agit ici de visualiser le positionnement de l’évaluation dans l’organigramme afin de détecter soit les composantes absentes soit les interrelations manquantes. Ou encore qualifier les interrelations entre les différentes entités ou postes chargés du Suivi Evaluation : support, accompagnement, formation, supervision, orientation…

En cas d’absence d’unité de Suivi Evaluation indépendante, ce qui demeure un scénario courant, l’enjeu est de redistribuer les attributs et prérogatives de l’évaluation indépendante au sein des instances de gouvernance existantes.

Une unité indépendante d’évaluation se construit sur les même fonctions qu’un système de suivi évaluation : pilotage, apprentissage, redevabilité.

Certaines responsabilités d’une unité indépendante d’évaluation méritent cependant d’être soulignées :

- impulser une démarche de transparence à destination des parties prenantes et du grand public

- nourrir la réflexion stratégique

- valider l’intégrité non seulement des processus techniques mais également des démarches évaluatives en terme éthique et déontologique

- contribuer à réduire les biais et améliorer la crédibilité

- définir le cadre de redevabilité

- garantir la remontée des voix des parties prenantes les moins audibles

- suivre et valider la cohérence au fil du temps entre le mandat/finalité de l’institution et sa déclinaison en actions

Dysfonction 2

Absence de connexions entre les différents services de Suivi Evaluation en externe

Cas de figure :

- Absence de connexions entre les différents services/départements dédiés à l’évaluation entre les multiples parties prenantes (ONG, institutions, collectivités locales,…).

- Absence pure et simple de service/départements dédiés au suivi évaluation et de ressources effectives allouées au suivi évaluation.

L’organisation de groupes de travail entre les différentes unités d’évaluation permet d’huiler les mécaniques, de croiser les questions évaluatives et de favoriser la cohérence globale des politiques publiques poursuivies. La sélection des indicateurs peut alors se réaliser conjointement en utilisant les mêmes unités de mesure afin de consolider et d’agréger les données.

Pistes d’amélioration :

- dès l’écriture du projet, incorporer systématiquement un pourcentage du budget global au suivi évaluation afin de permettre les ressources adéquates au suivi évaluation.

- inscrire les communautés de pratique, les retours d’expériences, les revues d’apprentissage comme principe intégré à la politique de suivi évaluation.

Dysfonction 3

Décalage entre la théorie et la pratique

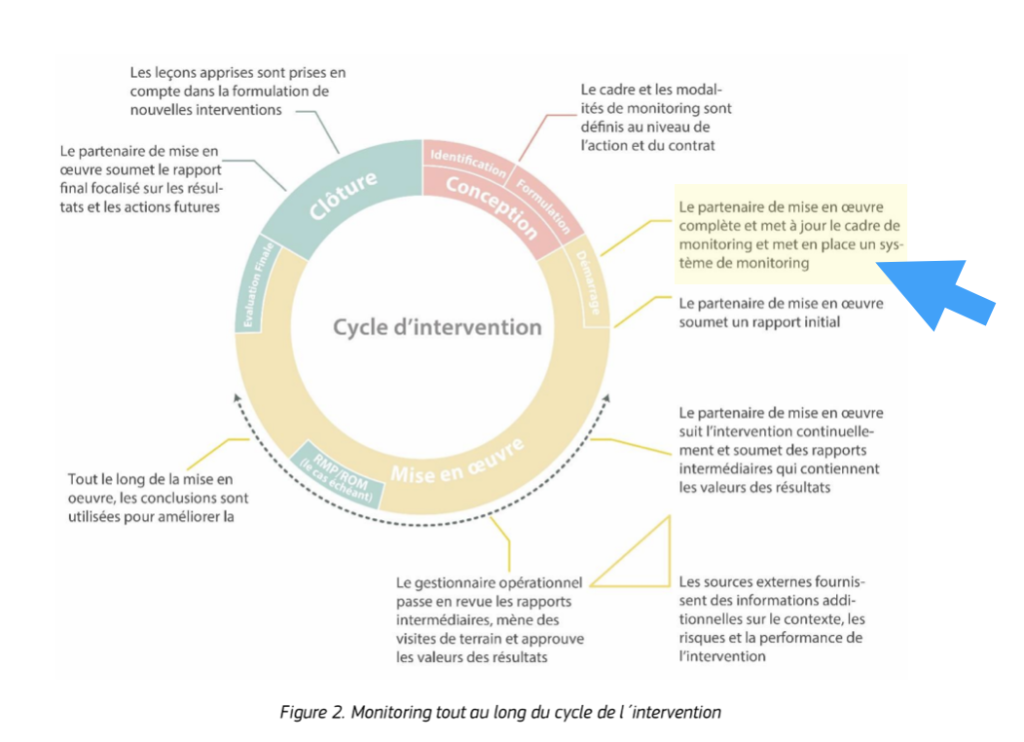

De nombreuses institutions ont désormais développé des guides et manuels afin de détailler les procédures sur lesquelles repose le suivi évaluation. Ces procédures reposent sur des normes et standards reconnus internationalement et déclinées en politiques de suivi évaluation à l’échelle institutionnelle. Il est courant de voir présenter en début de programme le dispositif de suivi évaluation envisagé à l’ensemble des parties prenantes lors du comité de pilotage. Il est beaucoup plus rare cependant de visualiser la matérialisation effective de ces systèmes au fil du temps et leur contribution aux objectifs poursuivis.

Conséquence :

Le Suivi Evaluation est perçu comme un passage obligé, un ensemble de pièces administratives en plus à fournir. L’utilité du Suivi Evaluation n’est pas démontrée, par conséquence elle n’est pas saisie.

Piste d’amélioration :

- formaliser les processus : transmettre le système de Suivi Evaluation au comité de pilotage avant la phase opérationnelle n’est plus une option mais devient un élément obligatoire ou contractuel. Même si, à ce stade, il ne peut s’agir que d’un brouillon avec toute latitude d’évolution ultérieure.

- renforcer les plans de développement des compétences en Suivi Evaluation et de montée en compétence au niveau opérationnel

Dysfonction 4

Confusion entre évaluation et auto-promotion

Cas de figure :

- les seules données mettant en valeur l’action sont partagées

- l’unité Suivi Evaluation est marginalisée (opacité sur le déroulé de l’action, absence de collectif, pilotage en huit-clos,…)

Le système de suivi évaluation s’envisage au regard de la finalité de l’institution qui le porte. Dans le cadre d’une mission de service public ou d’intérêt général, toute « production » du Suivi Evaluation devra ainsi incorporer une appréciation de l’atteinte de la finalité institutionnelle du point de vue des usagers.

A défaut, on invoquera une involution des buts, une propension à faire prévaloir sa propre réussite et par conséquence sa propre image sur les intérêts des publics que l’institution est mandatée pour servir.

Une ligne jaune infranchissable devrait ainsi être tracée entre les activités de storytelling et le suivi-évaluation.

Le storytelling ou la mise en récit est à l’origine une technique commerciale visant à promouvoir un produit ou une société à travers des histoires. Ajouter une dimension fictive et un narratif à une argumentation de vente.

Soit l’exact opposé de la démarche évaluative qui va chercher à construire un consensus à travers la recherche et l’exposition des différentes objectivités supposées. Produire des données tangibles afin de déconstruire autant que se peut la subjectivité.

Par ailleurs, pouvoir exprimer et visualiser des difficultés est une pré-condition à l’apprentissage.

Si les produits issus du SE se transforment en une litanie d’auto-satisfaction, alors l’apprentissage ne dispose d’aucune substance sur laquelle s’appuyer.

Enfin, une communication unilatéralement positive alors qu’aucun bénéfice ne se fait encore ressentir au niveau des usagers risque à terme d’affecter la crédibilité, non seulement du programme, mais aussi de l’institution qui le porte.

Pistes d’amélioration

- inscrire le principe de pluralité comme une dimension éthique de l’évaluation (prendre en compte les différents intérêts et recueillir une diversité de points de vue

- développer des mécanismes de gestion des plaintes afin de disposer de données pouvant contrebalancer des pratiques de mise en récit débridées

- proposer des exercices de mise en valeur d’échecs, par exemple des « contre-rapports annuels » (les équipes opérationnelles après lecture de l’extrait les concernant dans le rapport annuel expriment les plus gros ratés, passés inaperçus ou non, les conséquences sur l’action et les apprentissages à en tirer)

Dysfonction 5

Le suivi évaluation réduit à un outil de contrôle

Cas de figure :

Le Suivi Evaluation est réalisé à travers des données issues du reporting. Les formats de reporting se focalisent sur les résultats et notamment le premier niveau de résultats : les produits et services délivrés. Les chargés de Suivi Evaluation au niveau du terrain se transforment ainsi en opérateurs sur chaine de production dans des usines à « résultats ». Le dispositif se contente de pouvoir signaler des écarts. Il s’agit d’un simple exercice de supervision.

Parfois le versement de subvention par tranche est conditionné à la livraison des produits initialement fixés. La notion de partenariat entre financeur/bailleur de fonds et porteurs de projet pourra alors être interrogée lorsque ce type ce relation « contractuelle » ou commerciale est instaurée afin de générer un service d’intérêt général.

Pistes d’amélioration

- Les formats de reporting intègrent les capacités de départ en Suivi Evaluation et suivent la montée en compétences en SE des équipes.

- L’apprentissage est documenté au même titre que les résultats

- Fonctionner en terme de trajectoires plus que de résultats : détecter les trajectoires et les tendances

- Comme précédemment : systématiquement confronter les effets des produits ou services rendus à l’usager au mandat de l’institution qui finance (ou porte) l’action.

Dysfonction 6

Déséquilibre dans la répartition de la charge de collecte de données

Cas de figure

Dans un fonctionnement hiérarchique, chaque échelon se décharge de ses responsabilités en matière de redevabilité sur l’échelon inférieur. Le poids de la collecte et les ressources à mobiliser pour effectuer ce suivi affectent et retardent la mise en oeuvre. Les indicateurs sont centrés sur des résultats de premier niveau et ne renseignent pas la pertinence des choix stratégiques.

Pistes d’amélioration

- le système de Suivi Evaluation est conçu sur mesure et en fonction des capacités en Suivi Evaluation de l’équipe projet

- les questions évaluatives abordent le positionnement stratégique de l’action

- les séminaires trimestriels Suivi Evaluation Apprentissage permettent de réguler la charge de collecte et de suivre les questions évaluatives stratégiques à des échéances prédéterminées

Dysfonction 7

Absence d’espaces pour la mise en commun, l’échange et l’apprentissage

Cas de figure

De basiques réunions d’apprentissage sont estimées non-prioritaires et donc non programmées sur plusieurs années. Chaque réunion ou échange d’équipe est systématiquement technique ou lié à un ordre du jour très spécifique, sans possibilité de vision globale, de concertation et de fomentation d’objectifs partagés.

En terme d’analyse systémique, il s’agit du rejet implicite des principes de globalité et d’interaction. Le système est dysfonctionnel dû à une absence délibérée et volontaire de flux. Sur l’aspect fonctionnel, un centre de décision cautionne et arbitre de ne pas programmer de flux d’apprentissage quand bien même un élément structurel (par exemple des normes et standards d’évaluation validés de manière institutionnelle ou la politique institutionnelle d’évaluation) place ces flux d’apprentissage comme élément central. Il manque ici un centre de décision hiérarchique pour invalider l’arbitrage de non-programmation de réunions d’apprentissage. A l’extrême, il peut s’agir d’une dysfonction organisée, d’une volonté interne de rester au niveau de système à états (voir les différents types de systèmes de suivi évaluation) et de remplir de simples obligations contractuelles.

Conséquences

Les échanges s’effectuent de manière bilatérale, provoquant des délais liés à une rétention volontaire ou non d’information. Les acteurs avancent en silo sans possibilité d’échanges et d’élaboration d’une vision commune. Cette absence d’espace est une entrave à l’élaboration d’un esprit d’équipe, à la cohésion de groupe et harmonisation des pratiques.

Pistes d’amélioration

Systématisation des revues trimestrielles SEA présentées dans le cadre de la démarche HQSE. Dans un système fonctionnel les séminaires SEA servent néanmoins à l’évaluation du système de SE. A ce stade de dysfonction « hors norme », comme présenté dans le cas de figure ci-dessus, il convient surtout de mettre les acteurs autour d’une même table ainsi que de reformuler les normes et standards de l’évaluation afin de libérer la parole.

Dysfonction 8

Déficit de redevabilité

La redevabilité est la responsabilité de fournir des rapports d’avancement précis, honnêtes et crédibles.

Cas de figure

A plus de 18 mois du démarrage d’un programme, les pays partenaires n’ont pas encore reçu de rapport d’avancement, ni tenu de comité de pilotage.

Pour revenir à notre classification des systèmes, il s’agit d’un système à états, sans produit (output, le rapport d’avancement) et ainsi sans visibilité sur d’éventuelles données collectées (inputs, les entrées). A titre contractuel, le cadre logique précise les résultats attendus de la phase de mise en oeuvre mais ellipse totalement la phase d’installation. Aucun indicateur n’éclaire cette phase d’installation laissant libre court à la dysfonction 4 (distinction entre reporting et auto-promotion) lors de la diffusion éventuelle du rapport d’avancement.

En l’absence de flux, chaque fonction du sytème s’avère alors dysfonctionelle, les centres de décisions ne jouent pas leurs rôles, absences de boucles de rétroaction, pas de délai de réponse.

Bien sûr, des flux informels se mettent en place (mails, téléphone, rencontre physiques,…) face aux inquiétudes croissantes des élus et personnels en responsabilité, mais ceux-ci sont invisibles pour le grand public et entachent de nouveau la transparence/redevabilité. L’obligation de justification pour l’équipe de mise en oeuvre qui en découle remplace le reporting. Ces réponses à apporter aux préoccupations croissantes des parties prenantes sont alors ponctionnées sur le temps de mise en oeuvre et accroissent encore le retard vers la phase de distribution/production.

Conséquences

Interrogations sur la capacité de l’institution à mener le programme et décrédibilisation de l’ensemble des parties prenantes. Interrogation sur la stratégie développée par l’opérateur de mise en oeuvre.

Pistes d’amélioration

Elaboration de protocoles d’urgence menant à la tenue de réunions de crise au plus haut niveau des institutions concernées en cas d’écart trop important entre le prévisionnel et le réalisé. Inclusion de l’ensemble des acteurs dans ce protocole de crise afin de comprendre et visualiser les points de blocage.

Dysfonction 9

Absence de protocoles d’urgence

Cas de figure

Dans le cadre d’un fond d’urgence pour répondre à la crise du COVID, les premières subventions ne sont versées que 20 mois après l’annonce officielle d’un dispositif annoncé comme accéléré.

Conséquences

Les besoins des structures candidates au moment du versement de la subvention ne sont plus les mêmes que ceux émis au démarrage de l’épidémie. Le principe premier « Ne pas nuire » (do no harm) n’est pas respecté : les structures candidates, si elles avaient eu connaissance du délai de traitement, auraient eu d’autres priorités au coeur de la crise que de remplir ce dossier spécifique de demande de subvention.

Ce constat est également la conséquence de la dysfonction précédente, la capacité à renseigner des rapports d’avancement précis, honnêtes et factuels.

Pistes d’amélioration

- Mettre en place des protocoles d’urgences, des réunions de crise, inclusives, lorsque des indicateurs franchissent un écart-type non tolérable.

- Elaborer des scénarios alternatifs dans le cadre d’un plan de gestion de crise

Nous entrons ici au coeur des notions d’homéostasie et de téléologie. Le système de suivi et évaluation aurait du permettre de détecter des dysfonctionnements en amont et réguler les processus d’attribution des subventions pour rester dans des délais raisonnables. Ceci en distinguant :

i. les contraintes extérieures

ii. les dysfonctionnements internes

iii. la marge de manoeuvre pour une amélioration et un apprentissage institutionnel.

Le délai de versement des subventions aurait du figurer comme indicateur clé. Alors que ce n’est pas le cas et au regard des délais réels de versement des subventions, le principe premier de « ne pas nuire » devrait être questionné et s’autosaisir. Une déconnexion entre la finalité/raison d’être d’un organisme d’interêt général et son système de suivi évaluation.

Détecter une potentielle faille ou rupture dans son mandat devrait générer un scénario de gestion de crise.

Ce protocole implique à minima :

- la désignation des personnes en responsabilité

- un plan d’action

Ce protocole ne se substitue pas au système de suivi et évaluation bien sûr mais l’intègre. Il s’insère dans la même structure (limites, éléments, réseau, réservoirs) et s’incorpore dans les mêmes fonctions (flux, centres de décisions, boucles de rétroactions, délais de réponses). En terme de niveau, il ne peut s’agir que d’un système organisationnel : une appréciation d’une atteinte éventuelle au mandat ne peut être considérée que dans le cadre de la gouvernance globale de l’institution.

Dysfonction 10

Des indicateurs fantômes

La possibilité d’extraire du reporting les indicateurs dont les cibles ne sont pas atteintes

Exemple : dans un projet, une sous-composante est totalement abandonnée pour des raisons politiques qui dépassent l’équipe de direction du projet et qui ne sont jamais explicitées noir sur blanc. Les résultats du projet sont par ailleurs globalement excellents. Lors du dernier comité de pilotage vont être affichés les indicateurs de l’ensemble du projet… sauf de la sous-composante en question.

Laisser l’opportunité de « jouer au bonneteau » avec ses indicateurs ôte tout ou partie de l’intérêt de disposer d’un système de suivi et évaluation. Trouver les indicateurs disparus en cours de route permet à l’évaluateur externe de comprendre les enjeux et les réorientations.

Pour aller plus loin :

Etude de cas :

Ressources externes :

- 13 reasons why missions fail, Piret Tonurist, décembre 2023

- Qu’est-ce qu’un système de suivi évaluation ?

- Les différents types de systèmes de suivi évaluation

- Les dysfonctions de systèmes de suivi évaluation

- Un environnement propice à l’évaluation

- Un environnement propice à l’évaluation : quels leviers ?

- Les fonctions d’un SSE

- Le positionnement du SE dans un organigramme

- Le suivi évaluation dans le cycle de projet

Date de première diffusion : juillet 2023

Actualisation : mars 2025