Guides et manuels de suivi évaluation – par date de publication

Cette section propose différents guides ou manuels de Suivi Evaluation Redevabilité Apprentissage, triés par date de parution et organisation.

RESEAU FAR

Ce guide méthodologique présente un dispositif de suivi-évaluation (DSE) stratégique pour le Réseau FAR (Réseau international Formation Agricole et Rurale) pour la période 2022-2025. L’idée centrale est le passage d’un suivi-évaluation de projet, focalisé sur les indicateurs d’un cadre logique pour un bailleur, à un suivi-évaluation stratégique qui sert au pilotage global du réseau. Il s’articule autour de deux volets distincts : un volet « interne » pour suivre les activités de la direction exécutive (production de connaissances, communication, renforcement de capacités) et un volet « orienté changement » (AOC) pour analyser les processus complexes de structuration de ses réseaux nationaux membres. Le guide acte que les indicateurs de projet classiques sont insuffisants pour saisir la « complexité de la réalité ».

➡ une idée clé : considérer la progression d’un marqueur non pas comme une quête d’un score maximal, mais comme la visualisation d’une dynamique. Une échelle de changement peut être une priorité un temps (et donc progresser), puis ne plus l’être (et stagner ou régresser), sans que cela soit un échec. C’est le mouvement et la capacité d’adaptation du réseau qui sont valorisés, pas l’atteinte de cibles fixes.

UNESCO

Ce manuel d’évaluation vise à fournir des conseils pratiques pour la planification, la gestion, l’assurance qualité et la supervision des évaluations. L’évaluation est présentée comme un pilier de la gestion axée sur les résultats. Les auteurs évoquent des défis persistants dans la mise en œuvre effective de l’évaluation avec une insistance sur la formation obligatoire et la désignation des points focaux pour de structurer et professionnaliser la fonction. Une tension demeure entre la théorie (principes directeurs, normes) et la pratique (besoin de guidance concrète, d’outils, de renforcement des capacités) que le manuel cherche a atténuer. En terme de ressources, une préconisation est d’allouer un budget minimal de 3% des dépenses de programme à l’évaluation. Depuis 2016, se déploie une opérationnalisation de Focaux pour l’Évaluation (PFE), désignés au sein d’une unité administrative (secteur, bureau hors Siège, institut) pour « aider le personnel de programme à assurer la planification, la gestion et l’assurance qualité des évaluations décentralisées ». Le guide préconise l’intégration des groupes prioritaires comme les jeunes et les peuples autochtones, dans la conception même des évaluations.

➡ une idée clé : adapter la gestion et la méthodologie de l’évaluation aux contextes de crise et aux contraintes imprévues, comme les pandémies, en privilégiant la sécurité et l’éthique avant la rigidité planificatrice.

EUROPEAN UNION – Development Education and Awareness Raising programme

Ce guide méthodologique s’adresse aux acteurs du programme européen DEAR (Éducation au Développement et à la Sensibilisation) et propose un cadre de Suivi Evaluation Redevabilité Apprentissage afin de dépasser la simple mesure de résultats. A travers ce guide, l’UE insiste (enfin !) sur l’importance d’analyser la contribution d’un projet au changement plutôt que de chercher à en prouver l’attribution exclusive. Pour espérer saisir des changements complexes (comme l’évolution des mentalités), il est nécessaire de commencer par marier des données chiffrées (indicateurs de base) à des données qualitatives (récits de changement, études de cas). Le leitmotiv est posé : l’évaluation devrait impliquer toutes les parties prenantes (bénéficiaires, partenaires, etc.) et ne pas seulement répondre aux exigences du bailleur ; via une redevabilité qui soit à la fois ascendante (vers la CE) et descendante (vers les communautés). Une orientation majeure par rapport aux manuels précédents est la formalisation et la systématisation de la collecte de données qualitatives comme élément central et obligatoire de l’évaluation. Une déconnexion progressive se fait avec les cadres logiques rigides et les approches de suivi-évaluation purement quantitatives, perçus comme des exercices démesurément bureaucratiques. Le message sous-jacent est que la valeur d’un programme comme DEAR ne réside pas dans le nombre de brochures distribuées, mais dans sa capacité à enclencher des dynamiques de changement social. La recommandation de travailler en écosystème et d’analyser la cohérence avec d’autres initiatives est une réponse directe à la complexité et à la nécessité d’actions conjointes.

Une idée clé : « Instaurer un suivi évaluation (S&E) systématique va au-delà de la simple mise en place de nouvelles procédures. Il s’agit de créer une culture, un état d’esprit où la réflexion et l’apprentissage s’intègrent au travail quotidien. L’essentiel réside dans la manière de penser, et non dans les techniques spécifiques employées. » Anne Garbutt

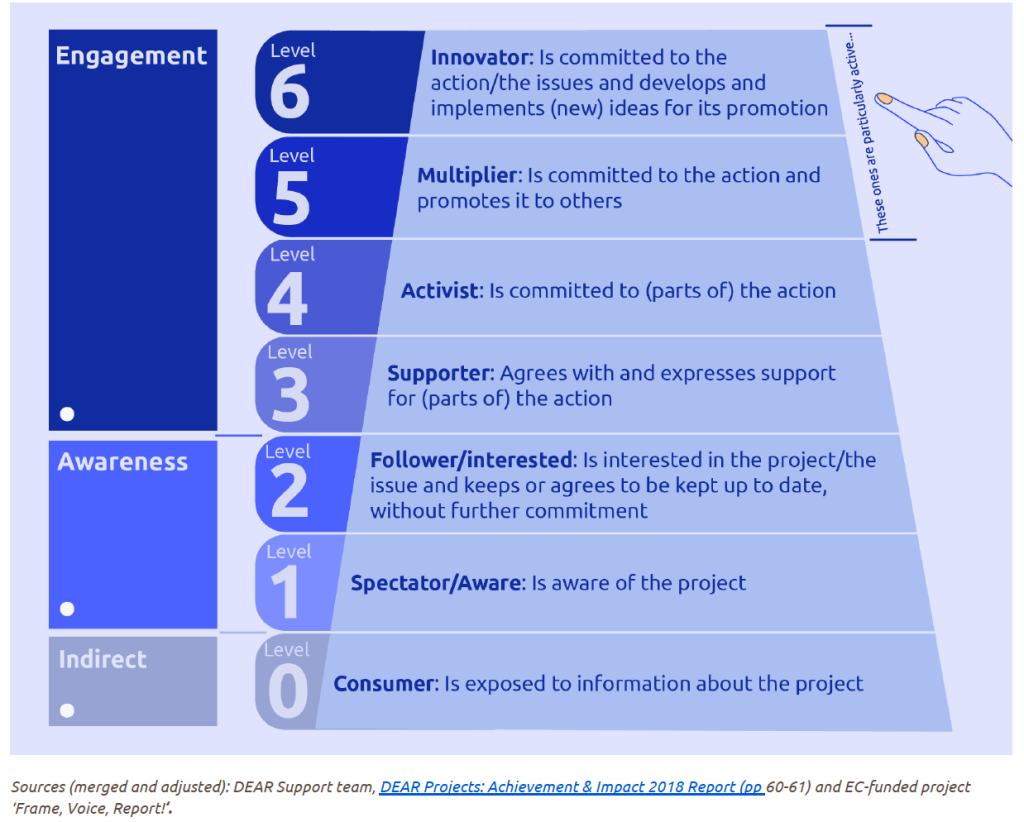

« Pyramide d’Engagement » pour catégoriser les personnes touchées par le projet. Au lieu de se contenter d’un chiffre global, cela mobilise les équipes à qualifier un niveau d’interaction (simple spectateur, sympathisant, activiste, etc.). Un outil visuel, qui permet de passer d’une mesure de l’atteinte (combien de personnes ont fait ci ou ça,…) à une mesure qualitative du type d’engagement.

IFAD

Ce manuel établit un cadre méthodologique unifié pour les évaluations au sein du Fonds international de développement agricole (FIDA). Son objectif principal est d’harmoniser, pour la première fois, les pratiques d’autoévaluation (menées par la direction) et d’évaluation indépendante (menées par le Bureau indépendant IOE). En adoptant la pensée systémique et des outils comme la cartographie des systèmes, le manuel reconnaît que le développement rural est un processus complexe, non linéaire, influencé par une multitude d’acteurs et de facteurs. Il s’éloigne d’une simple comptabilité des réalisations pour embrasser une analyse des dynamiques de changement, y compris les effets inattendus. Le manuel préconise des approches fondées sur la « théorie du changement » pour tester la logique de l’intervention. L’évaluation ne doit pas seulement mesurer les résultats, mais vérifier si les hypothèses sur la manière de les atteindre étaient correctes. Une recommandation pragmatique est l’utilisation systématique d’un barème de notation standardisé à six points (de « Très insatisfaisant » à « Très satisfaisant ») pour tous les critères d’évaluation (critères du CAD et critères spécifiques du FIDA : égalité des sexes et autonomisation des femmes).

Une idée clé : la nécessité pour les équipes d’évaluation de rencontres régulières afin de calibrer leurs jugement et s’assurer qu’ils interprète le barème FIDA de la même manière – en effet dans de nombreuses institutions les évaluateurs contractualisés pour les évaluations de programme ne se rencontrent jamais

IRC

- 2021 – Manuel Suivi, évaluation, responsabilisation et apprentissage (MEAL)

Standards, Pratiques et Conseils Techniques, International Rescue Committee

Cette actualisation des guides antérieurs, vise une harmonisation des pratiques de Suivi, Évaluation, Redevabilité et Apprentissage (MEAL) au sein de l’IRC. L’intégration explicite des retours clients tout au long du cycle de vie du projet est un élément central afin de conduire à des interventions mieux ciblées. Lorsqu’une évaluation externe est commanditée, l’équipe de programme décide des objectifs, tandis que l’équipe MEAL apporte un soutien technique substantiel sur des aspects tels que la rédaction des Termes de Référence (TdR), le budget et la méthodologie. Les conseillers techniques et les coordinateurs régionaux doivent approuver les TdR avant de démarrer le processus d’évaluation. Une recommandation est de toujours partir des données déjà disponibles afin de ne pas générer une lassitude de la part des répondants. Mais aussi la saisie systématique et régulière des données MEAL dans la base de données, illustrant les difficultés concrètes de terrain, une fois l’architecture du système précisé de lui donner réellement vie tout au long des activités opérationnelles. Contraintes de temps, manque de formation ou de motivation, problèmes matériels ou de connectivité,… Nous notons que les bénéficiaires de l’aide sont désormais appelés des clients, ceci afin de « mettre en avant notre conviction que les personnes que nous servons ont le droit de décider du type d’aide et de services dont elles ont besoin et qu’elles veulent ».

Ce document est intéressant car il clarifie la répartition des rôles et responsabilités entre les équipes de direction et les équipes MEAL.

FAO

- 2020 – Suivi, évaluation et apprentissage – Concepts, principes et outils, Agrinatura et FAO

Ce document présente le cadre, les objectifs, les principes et les outils du système de Suivi, Évaluation et Apprentissage (SEA) du projet de Renforcement des capacités pour les Systèmes d’innovation agricole (CDAIS). Mis en œuvre dans huit pays pilotes, ce système visait à soutenir l’exécution du projet et à prouver les changements induits, en se concentrant sur le renforcement des capacités fonctionnelles des acteurs à différents niveaux (individuel, organisationnel, systémique). Il s’appuie sur une approche participative et adaptative, utilisant des outils comme la cartographie des incidences pour favoriser le développement des stratégies d’intervention ou l’évaluation réaliste cherchant à comprendre les mécanismes de changement dans des contextes variés.

Le retour d’expérience évoque une adhésion non immédiate des équipes nationales, un apprentissage progressif et un accompagnement soutenu, un investissement en formation et une modification des cultures opérationnelles. Le succès de l’implémentation du SEA est fortement lié à la présence et à l’implication continue de points focaux dédiés.

La notion de seuil d’irréversibilité est présentée. Ce terme désigne le moment où l’appropriation des nouvelles approches et la prise de contrôle par les acteurs au sein du système d’innovation agricole sont si complètes qu’un retour à l’état antérieur ne semble plus envisageable. Le projet a « décollé » et vole de ses propres ailes.

AVSF

Ce guide est assez représentatif de la transposition du M&E dans les ONG françaises dans le courant des années 2000 (ce guide de 2020 est une réédition) avec toute sa panoplie : cadre logique, indicateurs SMART, critères du CAD (le critère de cohérence adopté en 2019 n’est cependant pas mentionné dans le guide), volonté de standardisation des outils.

Quelques spécificités : réaliser l’évaluation à mi-parcours en interne pour favoriser l’apprentissage avec des recommandations pragmatiques pour améliorer la deuxième partie du projet puis une évaluation finale externe afin de favoriser la redevabilité et en quête d’objectivité.

Egalement, une pré-sélection de 9 domaines de changements comme autant de variables vers lesquels braquer les projecteurs, afin d’orienter la sélection des indicateurs et s’assurer que les projets tendent bien vers les objectifs généraux d’AVSF. Par exemple et en premier lieu les changements de système de production mais encore les changements de mode de vie, les changements sociaux et économiques de la situation des femmes, l’incidence sur les politiques locales et/ou nationales,…

Ou encore des recommandations très pragmatiques : ne pas se surcharger d’indicateurs, mieux vaut un nombre limité d’indicateurs fiables que de se noyer dans une collecte de données trop complexes pour des retours incertains.

MSF Vienna

- Evaluation Manual, a handbook for initiating, managing and conducting evaluations in MSF, MSF Vienna, April 2017, 5th edition

MSF sur intégration de l’évaluation comme un processus continu d’amélioration de la qualité des opérations de MSF, plutôt qu’une simple inspection. L’ONG insiste sur la flexibilité et la créativité dans l’adaptation des processus d’évaluation aux besoins spécifiques de l’organisation, tout en maintenant la précision et la rigueur. La mention de « flexibilité et créativité » sous-entend la reconnaissance de la difficulté d’appliquer des cadres rigides dans des contextes humanitaires dynamiques. Quelques règles ou recommandations concrètes et pragmatiques :

Le rapport final d’une évaluation de projet ne doit pas dépasser 20 pages alors que les évaluations thématiques peuvent aller jusqu’à 50 pages. Ne pas émettre des recommandations pour « remplir », si on n’a pas quelque chose de concret à proposer, autant ne rien dire !

En bref, le manuel adapté aux acteurs de terrain cherche le bon équilibre entre rigueur méthodologique (critères, normes, méthodes de collecte de données) et la flexibilité nécessaire pour les contextes humanitaires d’urgence dans un cadre de mise en pratique utile et pragmatique.

Terre des hommes

- Concevoir et mettre en œuvre un système de monitoring, Terre des hommes, aide à l’enfance, 2016

Un guide essentiel qui reflète bien les multiples difficultés des acteurs de terrains dans la mise en place d’un système de suivi. Une surcharge de M&E qui se met au travers du déploiement des activités et non au service de l’action. Une surcharge de données qui ne sont pas exploitées. Des dispositifs de M&E techniques, déconnectés, isolés qui n’ont pas pris le temps de faire participer les parties prenantes. Des personnalités ou des cultures internes qui ne permettent pas la réflexion critique et tendent à cacher la poussière sous le tapis…

En bref, le monitoring est un outil de pilotage stratégique et opérationnel, pas seulement de reporting. Il est nécessaire de se libérer d’une vision du monitoring comme une contrainte imposée, focalisée sur le reporting aux bailleurs, pour être réellement utiles aux équipes opérationnelles et contribuer à la qualité du projet.

Save the children

Ce guide est intéressant dans le sens où il traite exclusivement de la redevabilité. Souvent noyée dans le MEAL, le document permet ainsi de dégager et de visualiser les composantes spécifiques à la redevabilité. Les piliers centraux incluent le partage transparent d’informations (y compris budgétaires), la participation significative des enfants et des communautés à toutes les étapes du cycle de projet , et la mise en place de mécanismes accessibles pour les retours d’information et les plaintes (CFM). Le document propose un outil d’auto-évaluation pour mesurer et planifier les améliorations en matière de redevabilité. L’idée principale est que la redevabilité ne se limite pas à rendre des comptes, mais implique de donner aux enfants et aux communautés une réelle influence sur les décisions et le pouvoir de demander des comptes à l’organisation. L’application des principes de redevabilité à chaque étape du cycle de projet (conception, mise en œuvre, suivi, évaluation, clôture) est une pratique standard.

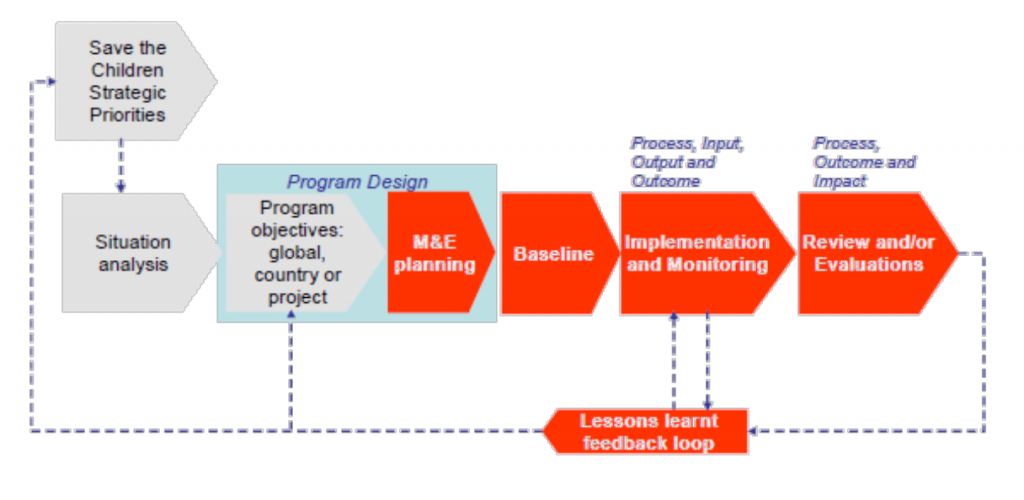

Le document décrit le système de Suivi, Évaluation, Redevabilité et Apprentissage (MEAL) de Save the Children, conçu pour améliorer la qualité des programmes et mesurer l’impact sur les enfants, en lien avec la stratégie globale de l’organisation. Les normes minimales doivent être spécifiques au projet, et doivent être établies par l’équipe de projet elle-même, plutôt que d’ailleurs dans l’organisation.

Il transparait une volonté d’aller au-delà de la simple collecte de données pour s’assurer que l’information soit activement utilisée pour questionner, apprendre et adapter les programmes. L’insistance sur l’utilisation des données pour la « prise de décision » laisse entendre que la principale difficulté récurrente reste que les données collectées restent sous-utilisées, à des fins de reporting uniquement. Une culture organisationnelle forte et l’engagement de la direction sont nécessaires pour le succès du MEAL.

L’organisation décline trois niveaux d’approche MEAL, allant du reporting de base à la recherche approfondie. Save the children préconise d’ajouter un point fixe à l’ordre du jour des réunions d’équipe existantes dédié à la revue des données MEAL (indicateurs clés, retours des bénéficiaires, progrès par rapport aux standards minimaux).

L’approche MEAL de Save the Children s’inscrit dans une idéologie de gestion axée sur les résultats (Results-Based Management) et d’amélioration continue de la qualité, courants importants dans le secteur du développement et de l’aide humanitaire depuis les années 1990.

➡ Save the Children produit environ 170 évaluations par an, internes ou externes.

Les rapports d’évaluation ont vocation à être partagés avec les collègues régionaux et mondiaux pour un archivage centralisé et une gestion partagée des connaissances.

IFRC (Fédération internationale des Sociétés de la Croix-Rouge et du Croissant-Rouge)

- Guide pour le suivi et l’évaluation de projets/programmes, Fédération internationale des Sociétés de la Croix-Rouge et du Croissant-Rouge, 2012

Politiques de suivi évaluation, par organisation

Handicap International/Humanity & Inclusion

- Politique de Planification, Suivi et Évaluation des projets, Politique institutionnelle, 2015, mise à jour 2018

Ce document de Handicap International établit un cadre pour la gestion de ses projets, centré sur la planification, le suivi et l’évaluation systématique. L’objectif est d’assurer la qualité des interventions, de favoriser l’apprentissage organisationnel et de renforcer la redevabilité envers les bénéficiaires, partenaires et bailleurs. Il introduit un « Référentiel qualité projet » comportant 12 critères et 36 engagements minimaux, applicable à tous les projets. L’accent mis sur la « mise en cohérence » interne laisse entendre la réponse à un besoin d’harmoniser les pratiques, d’établissement d’un langage commun et d’un cadre de référence unifié pour toutes les équipes projet.

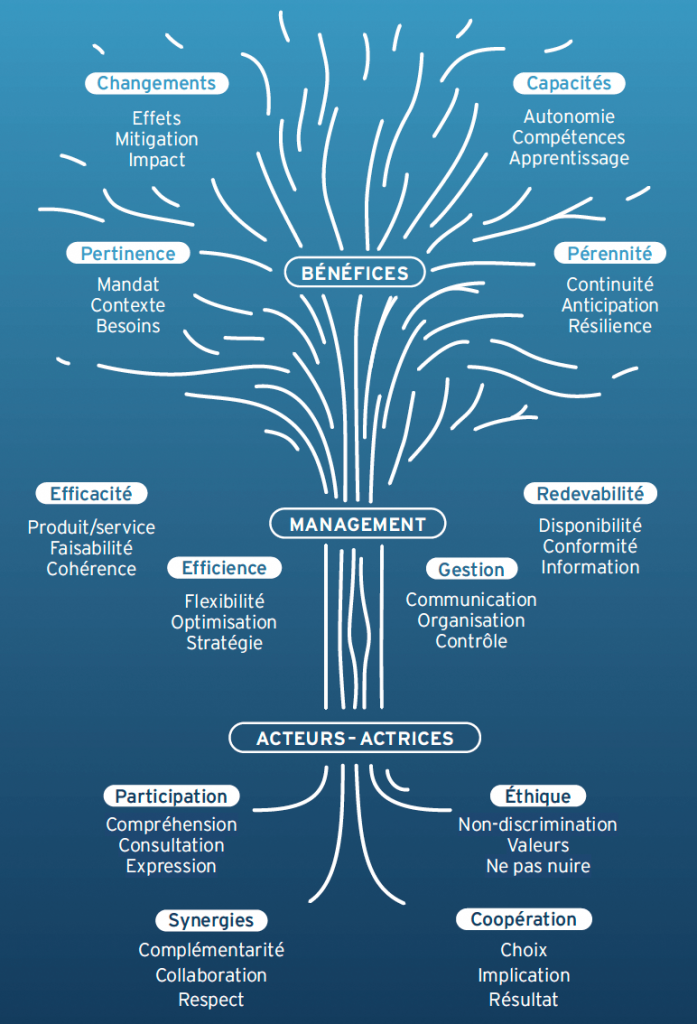

L’originalité est de dépasser les critères du CAD pour proposer 12 critères de qualité avec des engagements minimaux tout au long du cycle de projet. L’enjeu étant de ne pas transformer ce cadre en carcan mais support d’appui permettant de détecter des points de vigilance sur des faiblesses récurrentes de projets (synergie, renforcement des capacités sur la durée, etc.).

Agence Française de Développement

Trésor (Direction Générale du Trésor, Ministère de l’Economie et des Finances, France)

- Politique d’évaluation des activités de développement de la Direction Générale du Trésor, Avril 2017 (version précédente 2010)

Ce document de 2017 refond la politique d’évaluation des activités de développement de la Direction Générale du Trésor français. Il établit un cadre pour des évaluations systématiques et objectives, visant l’apprentissage et la redevabilité. S’inspirant des standards internationaux (OCDE CAD), il promeut l’impartialité, la crédibilité et l’utilité. Les évaluations, généralement ex-post ou intermédiaires, sont externalisées et suivent un processus structuré incluant une gouvernance claire (UEAD, comité technique, groupe de référence) et une réponse systématique aux recommandations. La politique souligne la coordination avec les autres acteurs français de l’aide (MAEDI, AFD) et s’inscrit dans les obligations légales de transparence et de suivi.

La description détaillée des processus et de la gouvernance peut être interprétée comme une réponse à un besoin de structuration interne et d’harmonisation des pratiques, mais aussi comme un gage de sérieux et de rigueur offert aux partenaires externes. Le budget de 480 000 euros et les 4 ETP de l’UEAD peuvent néanmoins s’avérer insuffisants face à l’ampleur des activités à évaluer et à la complexité croissante des enjeux de développement (climat, crises multiples). Ce budget permet de finaliser cinq à six évaluations par an. Cette politique s’inscrit dans le courant de la Nouvelle Gestion Publique (New Public Management), qui promeut l’efficacité, l’efficience, la redevabilité et la gestion axée sur les résultats dans le secteur public.

Oxfam

Ce document établit la politique d’Oxfam concernant l’évaluation de ses programmes humanitaires et de développement. L’accent est mis sur la capacité des bénéficiaires à demander des comptes à Oxfam avec l’engagement de consacrer au moins 1% du budget des programmes au suivi, évaluation et apprentissage (SEA). Tous les programmes doivent comporter un plan de suivi et d’évaluation, budgéter l’évaluation et définir les responsabilités. Le « renforcement de la capacité des bénéficiaires cibles à nous demander des comptes » suggère une volonté de corriger un déséquilibre de pouvoir inhérent aux interventions de développement et humanitaires. Par ailleurs, les rapports d’évaluation finaux sont publiés intégralement, sauf exceptions.

Ressources en évaluation dans le secteur du développement

- Gouvernance de l’évaluation

- Ressources bibliographiques

- Guides et manuels de suivi évaluation

- Guides et manuels : par secteur

- Guides, manuels et politiques d’évaluation par organisation

- Bases de données

- Plus de ressources en anglais

- Approches critiques de l’aide au développement

Date de première diffusion : 2018

Dernière actualisation : 2025