Corrélation

La corrélation est un concept purement statistique qui indique l’existence d’une relation ou d’une association entre deux variables. Lorsque deux variables sont corrélées, cela signifie que les changements observés dans l’une sont liés, de manière systématique, aux changements observés dans l’autre.

On distingue trois types de corrélation :

- La corrélation positive : les deux variables évoluent dans la même direction. Si l’une augmente, l’autre a tendance à augmenter également. Un exemple classique est la corrélation positive entre la hausse des températures estivales et l’augmentation des ventes de crèmes glacées

- La corrélation négative : les deux variables évoluent en directions opposées. Si l’une augmente, l’autre a tendance à diminuer. Avec la hausse de températures estivales, la baisse de la vente des appareils à raclette.

- La corrélation nulle : il n’existe aucune relation statistique apparente entre les deux variables. Le temps d’écran pour les ados et la vente de pamplemousse dans l’Arctique.

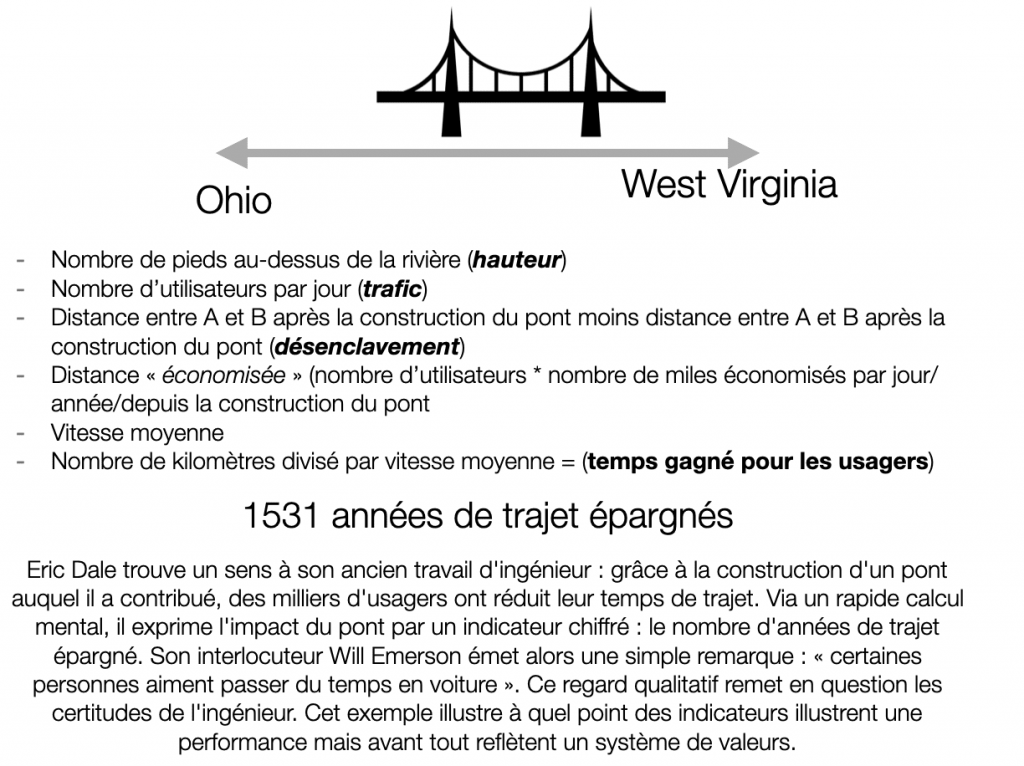

En évaluation, étudier une corrélation est une première phase d’analyse. Par exemple, est-ce que la construction de pistes cyclables augmente l’usage de la bicyclette ?

Comme exposé par le statisticien Edward Tufte, « la corrélation n’est pas synonyme de causalité, mais c’est certainement un indice« . Elle signale une relation à investiguer, mais ne dit rien sur la nature de cette relation.

Causalité

La causalité est un concept plus fort et plus exigeant. Elle signifie qu’un changement dans une variable, la cause, provoque directement un changement dans une autre variable, l’effet. Il s’agit donc d’une relation de cause à effet où l’une des variables influence directement l’autre. Cette notion, fondamentale pour la science moderne, a été formulée de manière concise par Galilée : « La cause est ce qui est tel que, lorsqu’elle est posée, l’effet s’ensuit ; lorsqu’elle est ôtée, l’effet est ôté« .

La distinction conceptuelle est fondamentale : la causalité implique toujours une corrélation, mais une corrélation n’implique jamais nécessairement une causalité. Si un projet cause réellement une amélioration, on observera une corrélation entre la mise en œuvre du projet et l’amélioration. Cependant, l’observation de cette corrélation seule ne suffit pas à prouver le lien de causalité.

Dans le cadre de l’évaluation de projet, on peut se demander si la construction de pistes cyclables incite les gens à faire du vélo, ou si les municipalités construisent des pistes cyclables en réponse à une demande croissante de cyclistes déjà existants. La relation peut également être bidirectionnelle, chaque variable influençant l’autre dans une boucle de rétroaction.

Corrélation n’est pas causalité

Exemple : pistes cyclables et commerces de proximité

Poursuivons sur ce même exemple lié aux mobilités douces.

- L’observation (la corrélation) :

Les politiques de promotion des mobilités douces, et en particulier du vélo, connaissent un essor sans précédent. Les collectivités investissent dans la construction d’infrastructures dédiées, comme les pistes cyclables sécurisées. Les données de comptage montrent presque systématiquement une augmentation de la fréquentation cycliste dans les zones où de tels aménagements sont réalisés.

Dans un territoire donné, les élus décident d’investir dans la création et la sécurisation de pistes cyclables sur une période de cinq ans.

En analysant les données économiques de la même période, on observe que dans les rues où de nouvelles pistes cyclables ont été aménagées, le chiffre d’affaires des commerces de proximité (boulangeries, kebabs, supérettes,…) a augmenté.

Ici, nous avons une corrélation positive :

- Variable A : le nombre de kilomètres de pistes cyclables.

- Variable B : le chiffre d’affaires des commerces locaux.

Lorsque la variable A augmente, la variable B a tendance à augmenter aussi. Les deux variables évoluent ensemble.

L’analyse : pourquoi ce n’est (peut-être) pas si simple

La conclusion hâtive serait de dire : « L’installation de pistes cyclables provoque une augmentation de l’activité commerciale. » C’est une hypothèse plausible (les cyclistes s’arrêtent plus facilement que les automobilistes pour un achat rapide, ils ont plus soifs, ils réinvestissent le temps gagné et l’argent économisé dans un café crème avec croissant sur une terrasse moins polluée qu’avant, etc.).

Cependant, la corrélation seule ne le prouve pas. D’autres facteurs pourraient expliquer cette tendance. Par exemple :

- Une politique globale de réaménagement : les pistes cyclables ont souvent été installées dans le cadre d’un projet plus large de réaménagement du quartier (trottoirs élargis, plantation d’arbres, limitation de la vitesse). C’est peut-être l’amélioration générale du cadre de vie qui a attiré plus de monde, et non uniquement les pistes cyclables.

- Un changement démographique (facteur caché) : Le quartier est peut-être devenu plus attractif pour de jeunes familles ou des ménages au pouvoir d’achat plus élevé, qui à la fois utilisent plus le vélo ET consomment plus dans les commerces locaux. Le changement de population serait alors la vraie cause.

3. Une tendance de fond : il y a peut-être une tendance générale, dans tout le pays, à un retour en grâce des commerces de proximité, indépendamment des aménagements cyclables.

En conclusion, la corrélation entre les pistes cyclables et la vitalité commerciale est un signal intéressant pour les urbanistes, les chargés de développement des territoires ou les élus. Mais pour prouver la causalité, il faudrait une évaluation plus poussée comparant ces rues avec des rues similaires n’ayant pas eu de pistes cyclables, afin d’isoler l’effet propre de l’aménagement.

Abuser du randomisé ?

Néanmoins, ces évaluations de type randomisées (voir Randomized Controlled Trial) auraient pour objet d’éclairer la prise de décisions des élus pour leur politique d’aménagement. Dans la pratique, voir ci-dessous l’exemple de l’évaluation de fin du projet Autrement qui n’arrive que pour constater des problématiques opérationnelles.

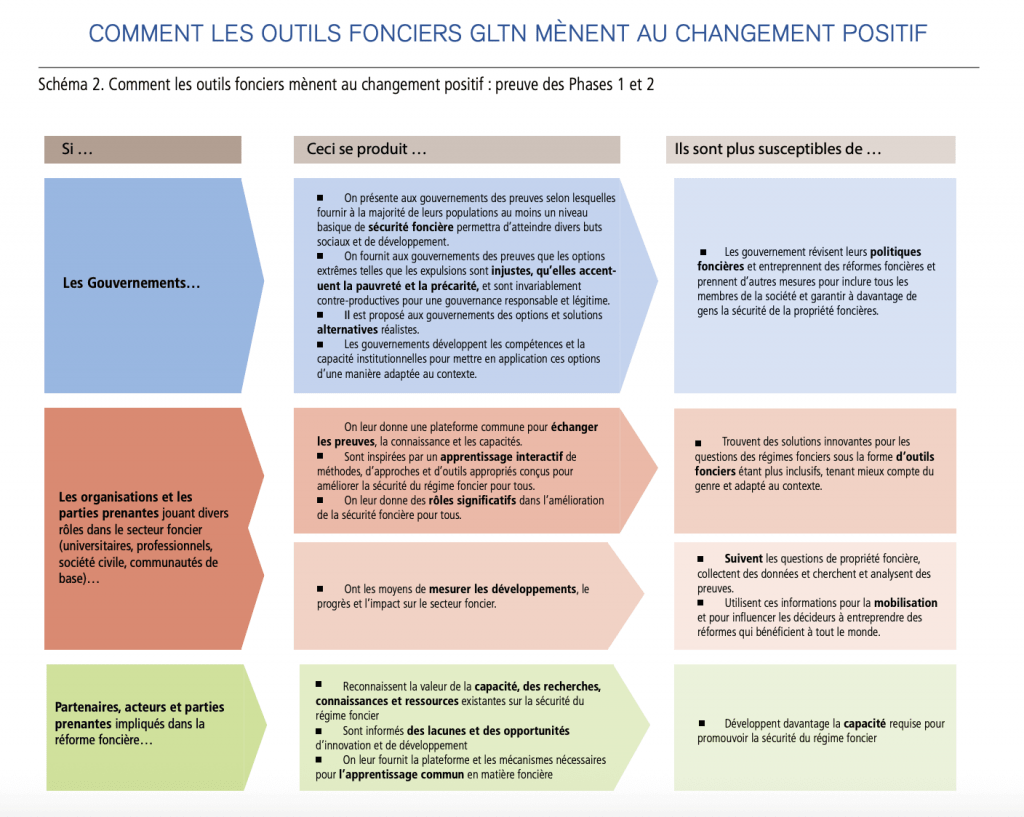

Analyser et atténuer les points de blocage en utilisant par exemple, comme support de discussion, la théorie du changement aurait permis d’amplifier les effets, à défaut de pouvoir les circonscrire pour les mesurer.

Un projet de mobilité douce ne réside pas seulement dans le produit final (les kilomètres de pistes peintes au sol), mais dans la transformation des processus de planification et de concertation qui y ont mené. La question n’est pas seulement « Les pistes cyclables ont-elles été livrées ? », mais « Comment leur tracé a-t-il été décidé et mis en œuvre ? ». L’effet causal de la démarche pourrait être d’avoir rendu le processus de planification plus inclusif en intégrant les associations d’usagers cyclistes et les commerçants dès l’amont, ou plus rigoureux en se basant sur des données fines de comptage cycliste et de sécurité perçue, ou encore d’avoir créé de nouveaux réseaux de collaboration pérennes entre les services municipaux (urbanisme, voirie, espaces verts).

Une opinion :

Les évaluations randomisés sont longues, complexes et donc couteuses. Dès lors qu’une corrélation forte est établie (même sous forme de convention sociale et non scientifiquement, par exemple « un ado est sera plus épanoui dehors à faire du vélo que toute la journée derrière un écran » ), l’enjeu est de multiplier les actions pour un rechercher un effet cocktail, par exemple : la construction de pistes cyclables plus l’organisation d’atelier de remise en état de vieilles bicyclettes plus initiation et permis vélo dans les écoles.

Mais une priorité serait de s’attaquer aux dysfonctionnements de mise en oeuvre opérationnelle qui sont récurrents, programme après programme : validations en silos, délais de décaissement anormalement longs, complexité administrative, déconnexion avec les utilisateurs finaux, projet en cycle court et unique,…

Les retards opérationnels sont les symptômes d’une gouvernance ou d’un management défaillant sur différentes échelles (ou sur l’articulation de ces échelles – communes, départements, régions, états, UE, associations d’usagers, etc.).

Pour aller plus loin

- Projet de coopération décentralisé Autrement : promouvoir les mobilités douces et la participation citoyenne

- Evaluation d’impact

Une explication en vidéo :