Adapter le périmètre du Système de Suivi et Evaluation (SSE) au niveau d’un portefeuille de projets ou de programmes est un exercice complexe. L’enjeu de redevabilité, par exemple, implique que certains indicateurs soient agrégés, que des données soient compilées afin d’éclairer les contributions à un niveau institutionnel.

Néanmoins, ce paramétrage, compilation d’indicateurs « prêt à porter », risque de générer une perte de sens et une incompréhension pour les équipes de mise en oeuvre, chargées de collecter ces données, qui ne reconnaissent parfois plus leur propre projet dans la palette d’indicateurs qui leur est proposée.

Notamment car la sélection de critères (puis les indicateurs en découlent) devrait permettre de visualiser l’identité d’un projet, de manifester ses valeurs, de comprendre ce qui fait sens pour les porteurs de projets comme pour les parties prenantes. Pour rappel, le système de suivi et évaluation ne sert pas uniquement à savoir si une action, un projet, une politique publique marche ou ne marche pas mais tout d’abord à exposer comment on sait si cette intervention fonctionne ou non.

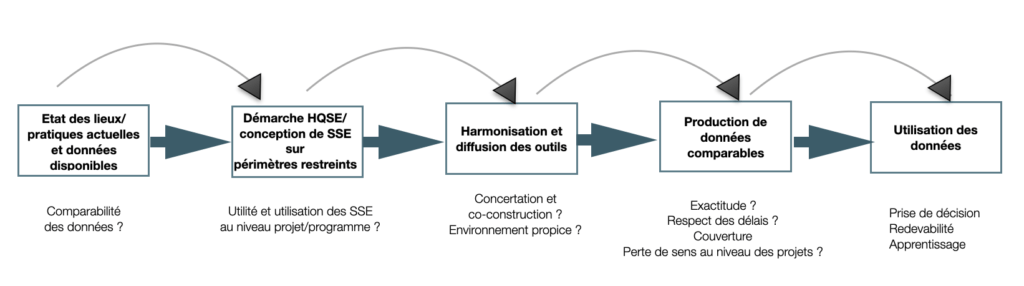

Une phase préliminaire de concertation et d’ajustement doit s’aborder dans un premier temps au niveau de périmètres réduits, à petite échelle : un projet ou une action unique et circonscrite. Une fois les Systèmes de Suivi Evaluation fonctionnels établis sur ces périmètres restreints et bien délimités, il est beaucoup plus aisé d’en partager l’utilité et d’impulser une direction transversale. Reproduire les 5 étapes de mise en place du système en élargissant à chaque fois le champs et en adaptant les questions évaluatives.

Partir du maillon le plus simple de l’action :

Etapes clés pour la mise en place d’un SSE au niveau d’un portefeuille de projets : quelques préconisations

Ces recommandations s’adresse aux structures dont les SSE sont encore balbutiants. Aux projets en phase de montage.

1. Etat des lieux des pratiques en termes suivi évaluation

Réaliser un état des lieux des pratiques actuelles, données disponibles et utilité du suivi évaluation au niveau institutionnel

2. Entamer à titre expérimental une démarche HQSE

➡ voir les 5 étapes de mises en place d’un Système de Suivi Evaluation

L’expérimentation devrait concerné dans un premier temps les périmètres les plus restreints (une seule action, une composante unique de projet, une région, etc.) :

- des expérimentations de mise de en place de SSE par des équipes projet distinctes

- des expérimentations de mise de en place de SSE sur différents territoires

- des expérimentations de mise en place de SSE sur différents volets ou composantes (santé, éducation, insertion, etc.)

3. Extraire des dénominateurs communs

- Détecter des questions évaluatives qui se recoupent entre les différentes actions

- Identifier des indicateurs existants proches ou communs :

- la définition de l’indicateur est-elle commune ?

- le mode de calcul de l’indicateur est-il similaire ?

4. Distinguer en termes de remontées d’informations ce qui doit rester au niveau du projet/programme et ce qui doit être transmis.

Les données utilisées ou non, exploitées ou non, analysées ou non par chaque acteur impliqué dans l’action. Les données utiles ou non pour chaque partie prenante (voir l’analyse des parties prenantes). Il s’agit de comprendre qui utilise quel type de données et à quelles fins.

5. Tester l’ensemble des outils

Parmi les remontées d’information sélectionnées pour une collecte transversale, tester avant la première échéance de rapportage auprès des chargés de Suivi Evaluation différents formats de canevas .

Par exemple pour :

- La sélection des indicateurs

- Les tableaux de suivi des indicateurs

- Les échelles de changement

- Les fiches de capitalisation

- Les formats de reporting

6. Validation terrain : garantir l’appropriation et l’adéquation des outils avec les besoins et capacités des équipes

Avant de diffuser ces premiers éléments du système, s’assurer que les équipes de terrain soient réceptives et en mesure d’utiliser ces outils, en fonction des informations collectées lors de l’état des lieux (concevoir un SSE : étape 1)

Notamment en ce qui concerne :

- La disponibilité des équipes (la charge de travail actuelle est-elle compatible avec un surcroit d’activités ? la mise en place du SSE risque-t-elle d’affecter la prise en charge des usagers ou la qualité de service ?)

- L’intérêt pour les questions évaluatives (les questions sélectionnées font-elles sens aussi bien au niveau du siège que du terrain ?)

- Les compétences des équipes et formations préalables en Suivi Evaluation

- Les moyens alloués à la fonction Suivi Evaluation

7. Alignement stratégique : confronter les retours d’information aux valeurs et fondements de la structure qui porte l’action

Cette étape consiste à analyser de manière critique les informations initiales recueillies, en les comparant avec les valeurs fondamentales de l’organisation. L’objectif est d’identifier les complémentarités (synergies) possibles ainsi que les points de friction ou d’opposition (antagonismes) qui pourraient émerger.

Exemple : projet d’autonomisation des jeunes

Un nouvel indicateur standardisé de « taux de placement en emploi durable à 6 mois » est introduit pour tous les projets. Première remontée d’information : les équipes de terrain signalent que pour atteindre cet indicateur, certaines antennes sont tentées de sélectionner les jeunes les plus « faciles à placer », laissant de côté ceux ayant des difficultés plus importantes. Un partenaire local (association de quartier) se sent moins consulté depuis la mise en place du tableau de bord numérique, car les informations sont désormais directement envoyées au siège et moins partagées qu’auparavant. Simultanément, une nouvelle procédure de rapportage mensuel est mise en place. Les équipes de terrain trouvent cette procédure très chronophage, réduisant le temps qu’elles peuvent consacrer à l’accompagnement direct des jeunes.

En quoi et comment le système proposé peut-il s’intégrer et s’inscrire dans le fonctionnement plus global de l’institution ?

En terme de :

- Statut ou politique SE

- Charte SE

- Manuel SE

- Outils de gestion de projets

- Pratiques (existe-il un décalage entre le siège et le terrain ?)

- Communication des résultats du SE (par exemple le rapport annuel ou rapport d’activités : communication sur les échecs également ou uniquement ce qui flatte l’équipe de mise en oeuvre ?)

Et bien sûr en terme de qualité des données :

Suivi des flux de données

Même si le flux des données est avant tout ascendant (de l’usager vers l’équipe projet, de l’équipe projet vers son siège, du siège vers le bailleur de fonds, etc.) la redevabilité finale envers l’usager devrait être suivie et évaluée. Quelle proportion d’évaluations finales est accessible libre-accès ? Le programme des évaluations finales à venir est-il disponible ?

Pour aller plus loin :

- Quelles sont les fonctions d’un système de suivi et évaluation ?

- Le positionnement du SE dans l’organigramme

- Les principales phases de mise en place d’un SSE

Date de diffusion : février 2019

Date de mise à jour : mai 2025

Sébastien Galéa